近日中國上海的AI公司 MiniMax 日前宣布,將其最新的大語言模型(Large Language Model, LLM)「MiniMax-M1」正式開源。MiniMax-M1 最大的亮點在於其支援長達100萬個輸入Token、8萬個輸出Token的上下文視窗,這是目前開源模型中最長的上下文處理能力,遠遠超越了目前市面上許多主流模型。例如,與中國另一開源模型DeepSeek R1相比,其上下文視窗長度整整是對方的8倍。MiniMax-M1 也是全球首個開放權重(open-weight)且具備混合注意力機制的推理模型(hybrid-attention reasoning model)。

混合架構設計:MoE與Lightning Attention雙引擎驅動

MiniMax-M1 的基礎架構源自先前的 MiniMax-Text-01 模型,但在設計上大幅升級,採用了混合專家架構 Mixture-of-Experts(MoE)以及名為Lightning Attention的高效注意力機制。該模型總參數高達4560億,但在每次推理中實際活躍的參數僅為459億,透過MoE有效提升效率並減少計算負載。

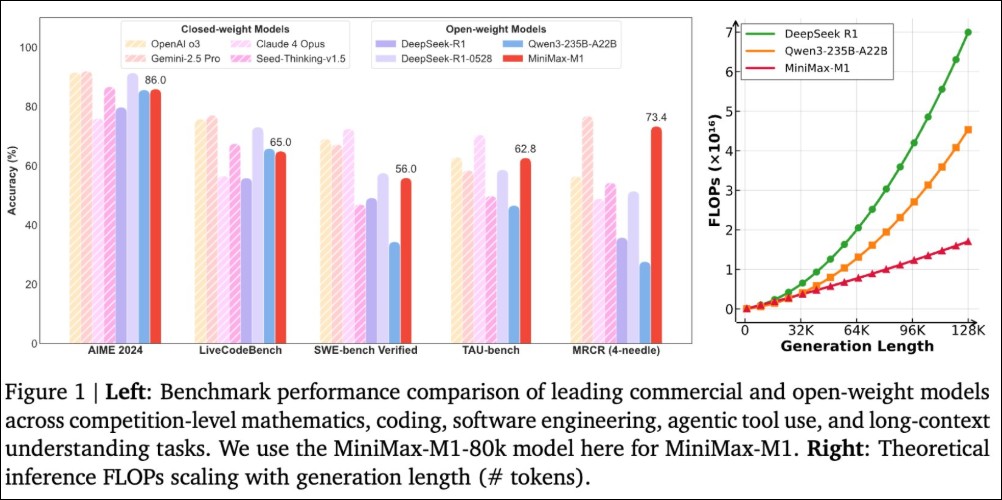

Lightning Attention則專注於計算效率的極致優化。MiniMax官方指出,在使用10萬個Token上下文長度進行推理時,MiniMax-M1所需的FLOP(每秒浮點運算次數)僅為 DeepSeek R1 的25%。這代表該模型特別適用於處理需要大量記憶與長期推理的複雜任務,實現「深思熟慮」的AI輸出。

Day 1/5 of #MiniMaxWeek: We’re open-sourcing MiniMax-M1, our latest LLM — setting new standards in long-context reasoning.

– World’s longest context window: 1M-token input, 80k-token output

– State-of-the-art agentic use among open-source models

– RL at unmatched efficiency:… pic.twitter.com/bGfDlZA54n— MiniMax (official) (@MiniMax__AI) June 16, 2025

性能對比:在多項專業任務上表現不輸商用模型

從官方釋出的對比圖表來看,MiniMax-M1在下列多項任務中表現出色,包括:

-

專業級數學推理

-

程式碼生成與理解

-

軟體工程模擬

-

多工具AI Agent使用能力

-

長文本理解與生成任務

在這些任務中,MiniMax-M1與主要商用AI模型(如OpenAI、Anthropic等)的表現幾乎旗鼓相當,有些場景甚至略勝一籌,顯示其開源身份並未犧牲模型能力。

MiniMax-M1 實際應用案例

MiniMax-M1的實際應用範圍廣泛,且上手門檻極低。官方與使用者分享的案例顯示,只需輸入簡單的提示詞,即可快速生成可直接部署的應用程式或HTML頁面,無需額外外掛或手動設定。

案例一:動畫粒子背景HTML頁面

透過如下提示:「請建立一個帶有動畫粒子背景的HTML頁面,粒子會平滑移動並在接近時連線,並於中央加入標題文字」,MiniMax-M1生成的HTML頁面完美展示了Canvas與JavaScript互動動畫效果,符合現代網頁設計標準。

案例二:打字速度測試網頁

使用者輸入請求:「請建立一個能即時追蹤WPM(每分鐘打字字數)的網頁應用程式」,MiniMax-M1隨即生成一個功能完整、界面乾淨的打字測試網站。這樣的應用不僅具備教學價值,也能直接投入實際使用環境。

案例三:迷宮生成與路徑尋找視覺化工具

另一位使用者則請求生成一個隨機迷宮生成器,並能視覺化展示路徑尋找算法的過程。MiniMax-M1在Canvas上以動畫形式動態展現了演算法逐步解迷的過程,結合了AI生成與教育視覺化技術。

案例四:Netflix風格預告片應用

X 用戶 @Min Choi 分享了以 MiniMax-M1 製作的 Netflix 網站 1:1 仿製頁面、以色列與伊朗衝突即時頁面等共十個案例,能夠即時播放預告片並模擬影片展示平台的使用介面,進一步展現 MiniMax-M1 在前端開發與 API 整合的實戰能力。他稱可取代 Manus、Lovable 與 Deep Research 等AI應用。

This is wild.

MiniMax-M1 just dropped.

This AI agent = Manus + Deep Research + Computer Use + Lovable in one.

1M token memory, open weights🤯

10 wild examples + prompts & demo:

1. Netflix clone with playable trailers pic.twitter.com/mfpzrCwlot

— Min Choi (@minchoi) June 16, 2025

AI 策略顧問 David Hendrickson 針對 MiniMax-M1 與 Anthropic 的 Claude Opus 4 進行了一系列比較測試。他指出,在部分長上下文驅動的基準測試中,MiniMax-M1的表現甚至超越了Claude Opus 4,這對於尚處於發展中的開源模型而言,是極具指標性的成果。

Compare the newly released MiiniMax-M1 80B against Claude Opus 4. MiniMax outperforms Claude Opus 4 in some benchmarks, especially in long-context driven benchmarks. https://t.co/XIiEovh7wB pic.twitter.com/0PgPi7bk3E

— David Hendrickson (@TeksEdge) June 16, 2025

有限資源下,以創新方式作出驚艷產品

MiniMax 隸屬於由騰訊與阿里巴巴等中國科技巨頭支持的AI新創企業群體,之前比較出名的應用是聲音克隆產品。可能是受到 DeepSeek 啟發,MiniMax 選擇透過「高效率訓練」與「開放權重策略」另闢蹊徑,建立一條成本可控又技術先進的開發模式。根據 MiniMax 在 X 的貼文表示 MiniMax-M1的訓練預算僅為53萬4700美元(約合新台幣1,570萬元),相較動輒耗資上億美元的商用AI模型而言,這顯示了技術效率與資源管理的優勢。MiniMax 與 DeepSeek 的成功證明,即使在預算與算力有限的情況下,透過技術的創新,依然能開發出具競爭力的尖端模型。

如需深入了解MiniMax-M1,可造訪其GitHub專案頁面與Hugging Face模型集區。