最近 AI 瀏覽器可說越來越多,不只是 Dia、Perplexity,就連 OpenAI 也計劃推出,但事實上現在已經有一款 BrowserOS 開源 AI 瀏覽器超級好用,內建免費 AI 代理,你只需要用自然語言,就能要求 AI 幫你操作任何內容,像是到購物網站上查詢某項產品,AI 也能讀取當前打開的網頁,讓你能詢問相關問題,更重要是,還可以在側邊欄打開 ChatGPT、Gemini、Grok 等 AI 服務。

對於很在意數據的人,BrowserOS 也支援串接本地 Ollama 下載的指定模型,很推薦大家玩玩看,Windows、Mac 都能裝。

BrowserOS 超強免費開源的 AI 代理瀏覽器介紹和操作教學

BrowserOS 是一款開源的 AI 代理瀏覽器,有在 GitHub 分享原始程式碼,有興趣的人可以去了解。官網有提供 Windows 和 Mac 的安裝檔,讓即使沒有程式背景的使用者,也能輕鬆安裝這款瀏覽器。

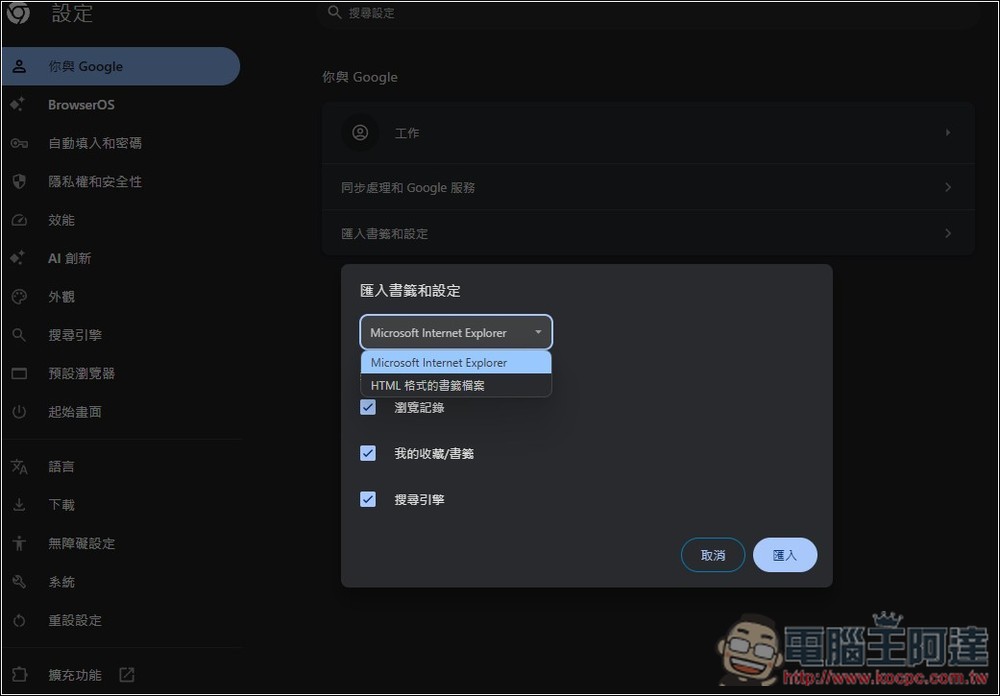

此外,BrowserOS 也是基於 Chromium 核心開發的,意味著你可以將 Chrome、Edge 等瀏覽器的數據匯入,讓你能無痛轉換。

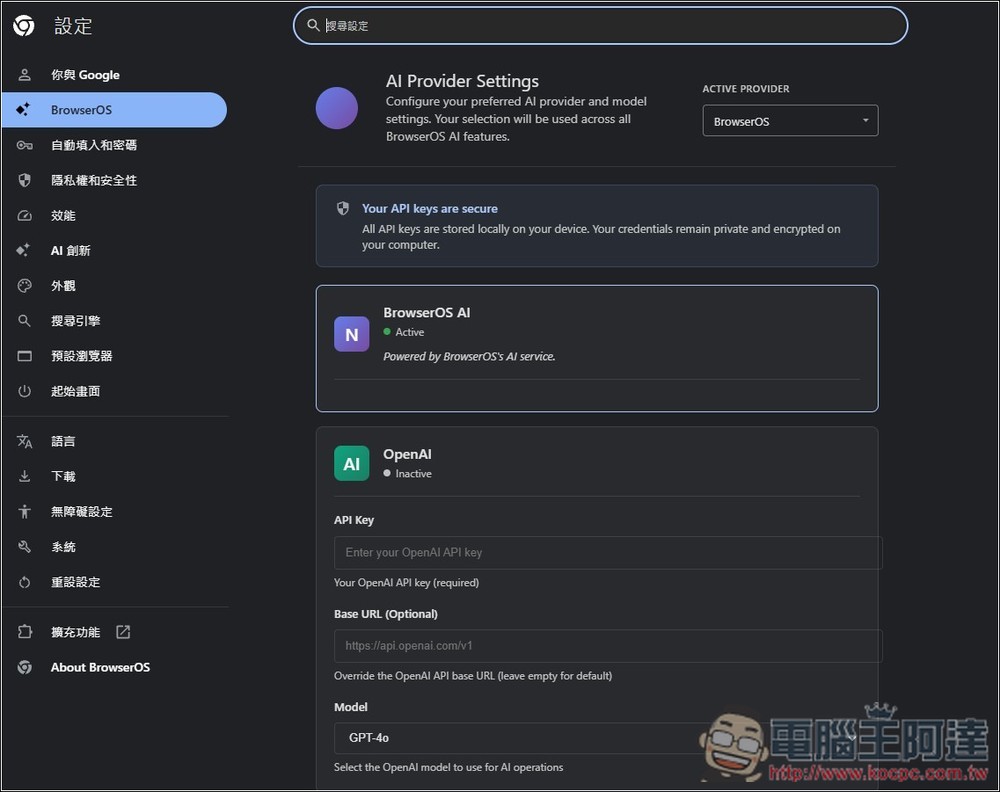

BrowserOS 本身就有內建自己的 BrowserOS AI,下載之後就能直接免費用,一般的 AI 聊天、AI 代理都行。如果你用不慣,也可以改用 OpenAI、Anthropic 或 Gemini,但要填寫自己的 API Key,Ollama 部分只要下載支援的模型,就能串接使用。

按上方連結進到 BrowserOS 後,填寫你的 E-mail,就能獲得 Windows 和 Mac 的安裝檔載點:

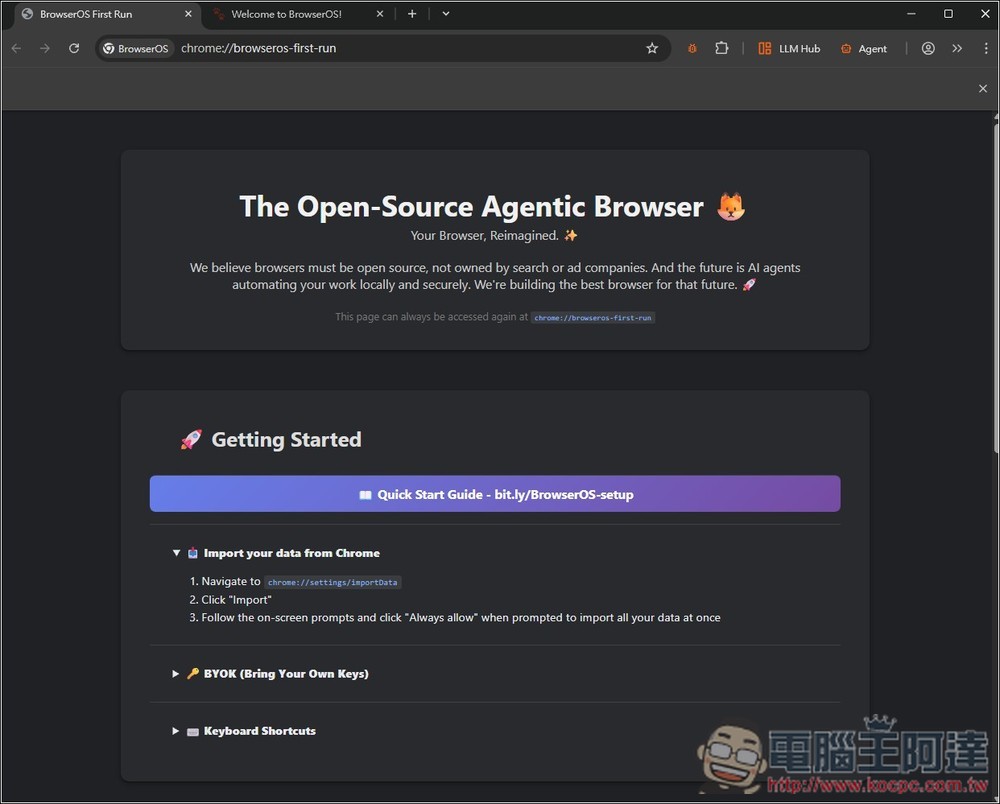

首次打開 BrowserOS 瀏覽器,會出現開始頁面,如果你想要把 Chrome 或 Edge 的數據匯入,按第一個 Import your data from Chrome 的 Navigate 右邊網址:

就會進到設定中,讓你能匯入書籤和設定:

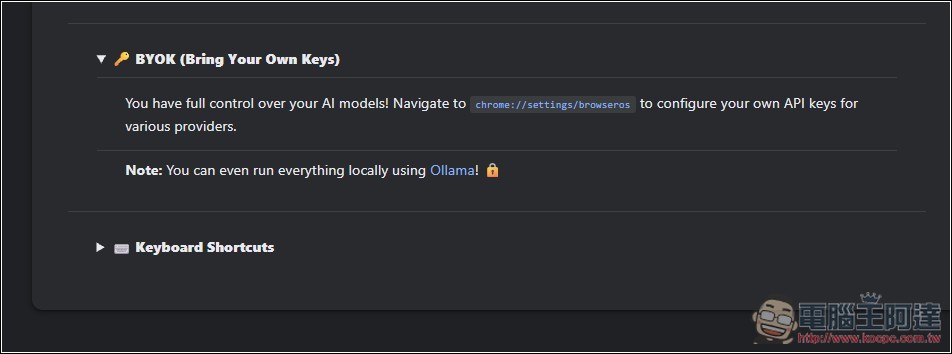

第二個 BYOK 則是設定 AI 模型,點一下上面的網址:

會進到這頁面,這就是 AI 提供商的設定,預設是 BrowserOS AI,下面有其他 AI 服務能選:

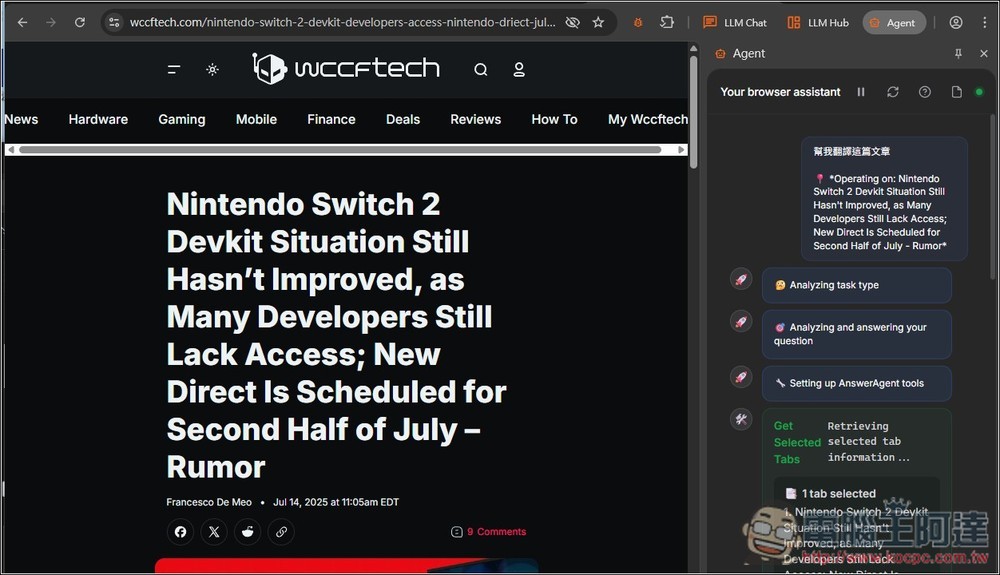

AI 的使用方式很簡單,以基本的聊天來說,進到任何頁面,像我隨便打開一篇英文新聞,然後按右上角的 Agent,側邊會開啟聊天欄,接著就能給 AI 你的需求,我要求它幫忙翻譯這篇文章,BrowserOS AI 就會開始執行這任務,並調用適合的工具:

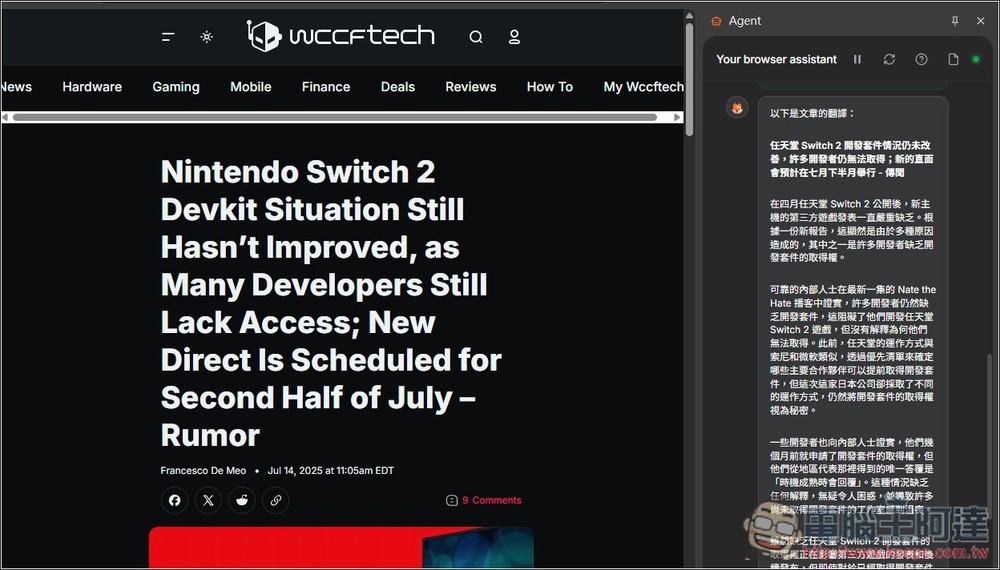

接著就能獲得答案,也就是我要求的翻譯:

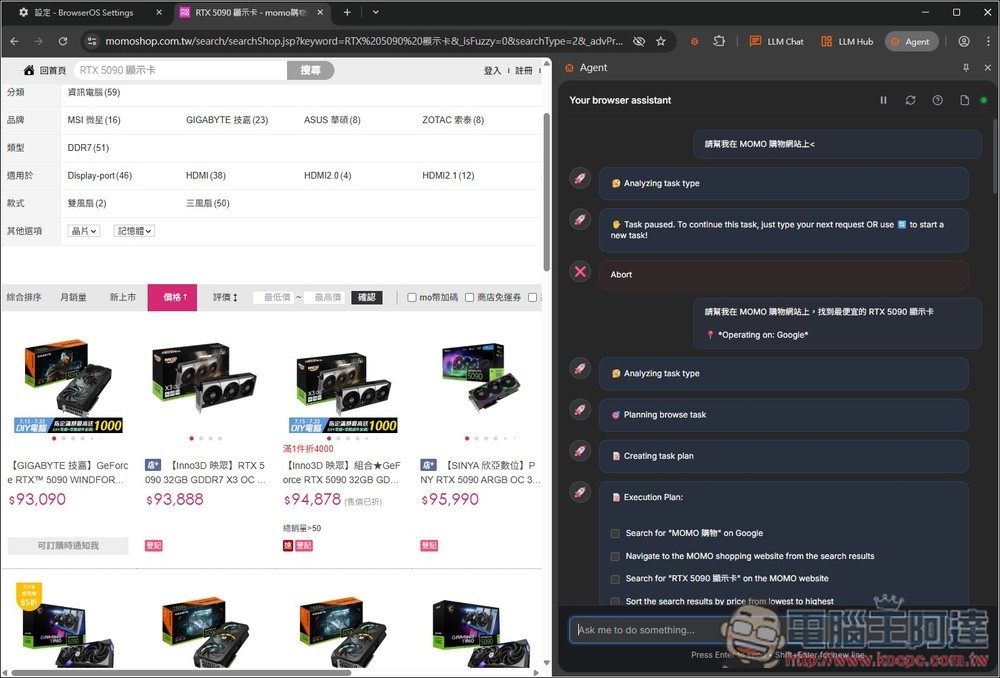

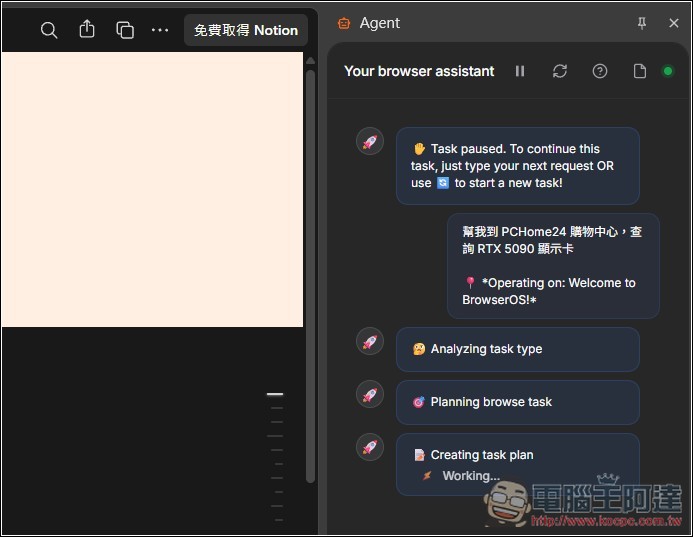

而 AI 代理自動任務操作也一樣,就在 Agent 聊天中給它任務,下圖我叫它幫我到 PCHome24 購物中心,查詢 RTX 5090 顯示卡:

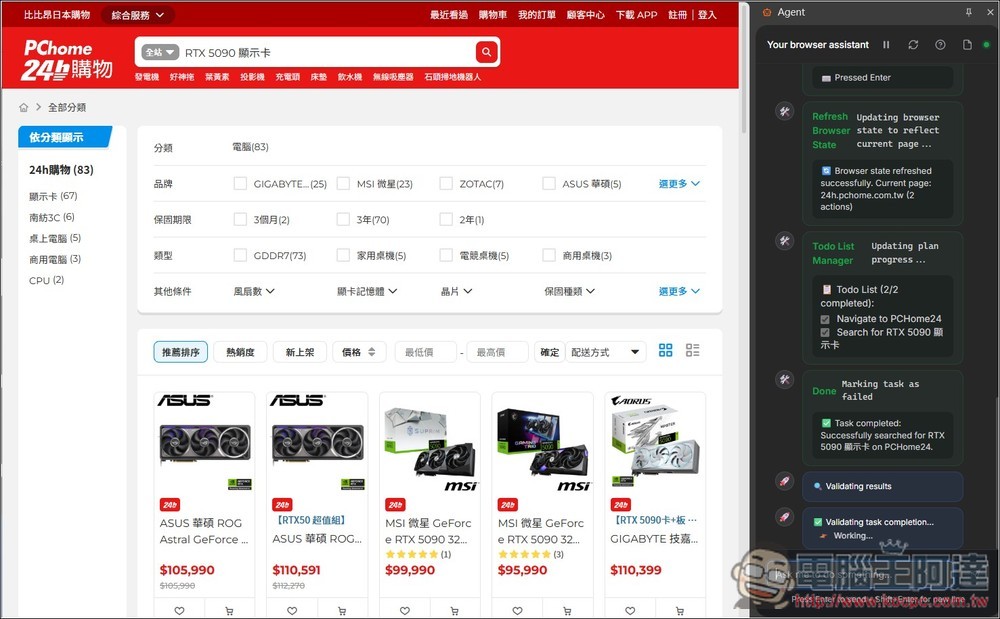

給完任務後就能放開雙手,你會看到 AI 正在自動操作這個瀏覽器,以我的來說,他會打開 PChome24h 購物,然後找到輸入框並搜尋 RTX 5090 顯示卡,畫面也會即時顯示它的操作:

完成我要求的任務:

AI 聊天和 AI 代理能做到的事情非常多,大家可以自己玩玩看。

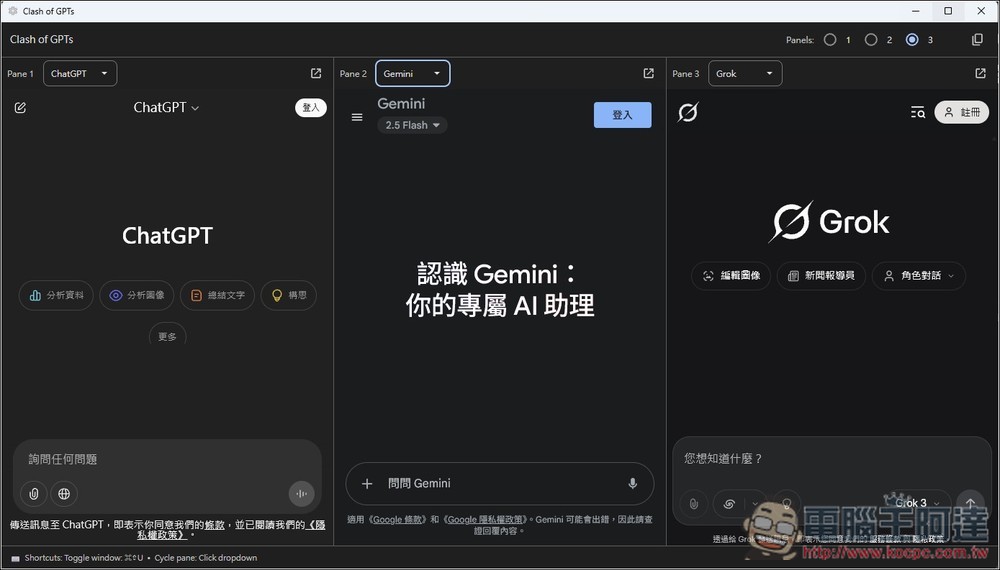

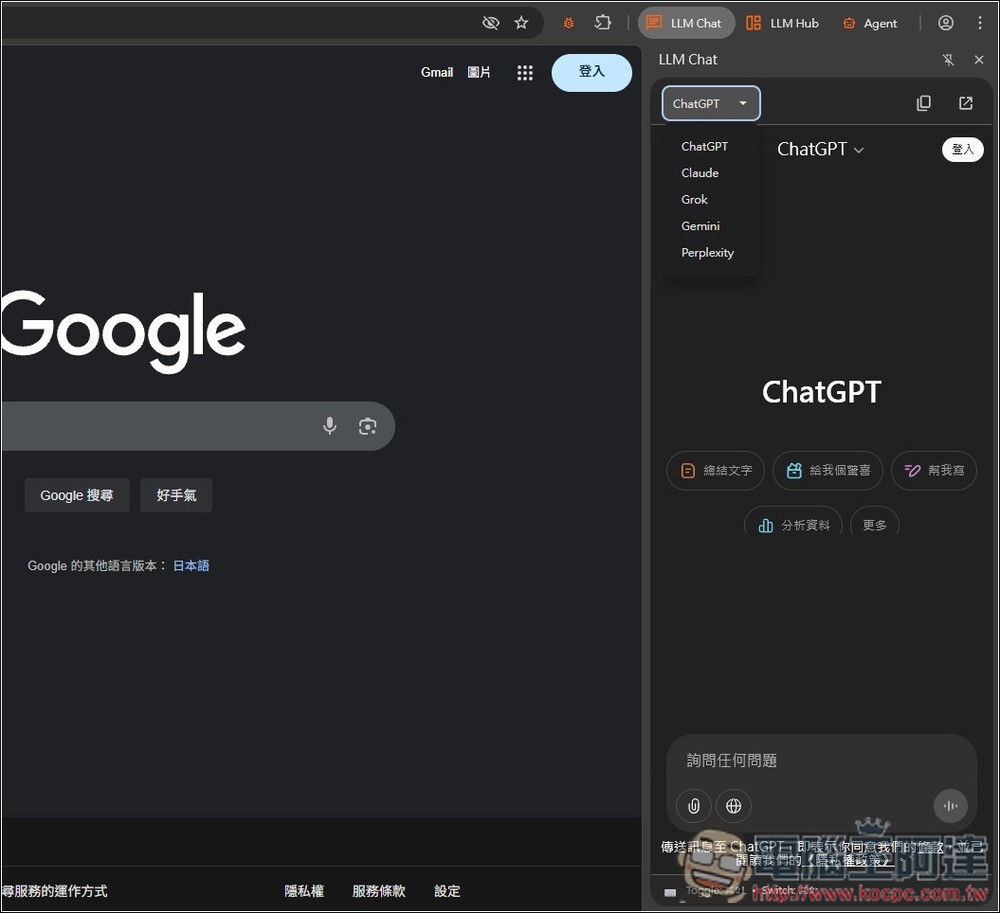

而 LLM Chat 就是把市面上知名的 AI 服務在側邊欄打開,支援 ChatGPT、Claude、Grok、Gemini 和 Perplexity,方便你快速使用,但不支援讀取當前開啟的網頁內容:

LLM Hub 可一次開啟最多 3 個 AI 聊天服務,讓你能快速比較不同 AI 給出的答案:

如何串接本地 Ollama 模型

對於在意自己數據的人,可以改串接 Ollama 下載的模型,但不是每一個都支援,且就算支援,你也必須自行設定各需求所調用的工具,難度較高,僅推薦給進階用戶,或是你願意花時間研究。

另外使用的模型都要 10b 以上,意味著你的顯示卡記憶體至少要 16GB 以上會比較好,12GB 跑起來很慢。

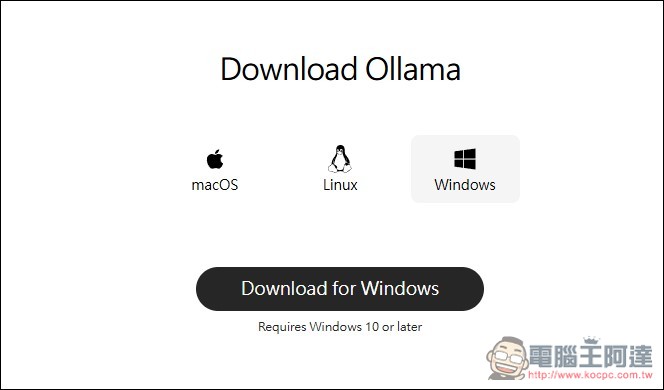

首先,你的電腦必須要有 Ollama,沒有的人可至官網下載安裝檔:

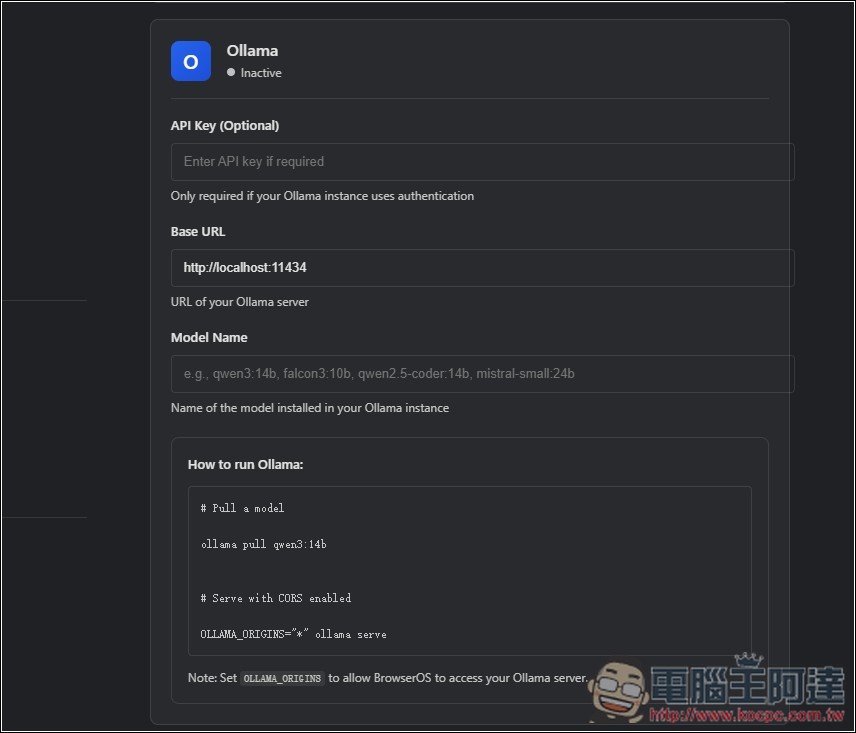

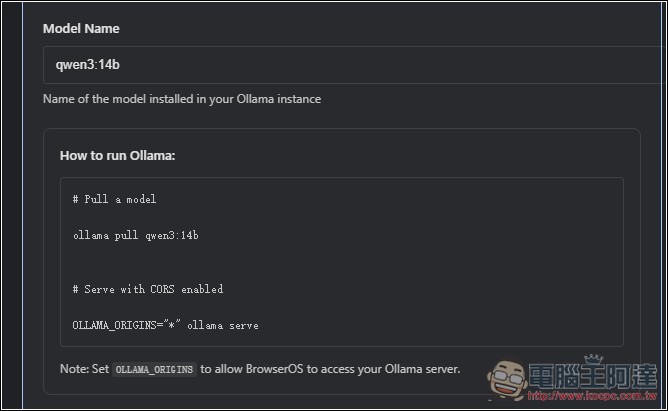

Ollama 就在 BrowserOS 設定中的下方,基本上只需要填 Model Name,目前支援的模型有 qwen3:14b、falcon3:10b、qwen2.5-coder:14b、mistral-small:24b,另外下方的 How to run Ollama 等等也會需要用到,可以先記下來:

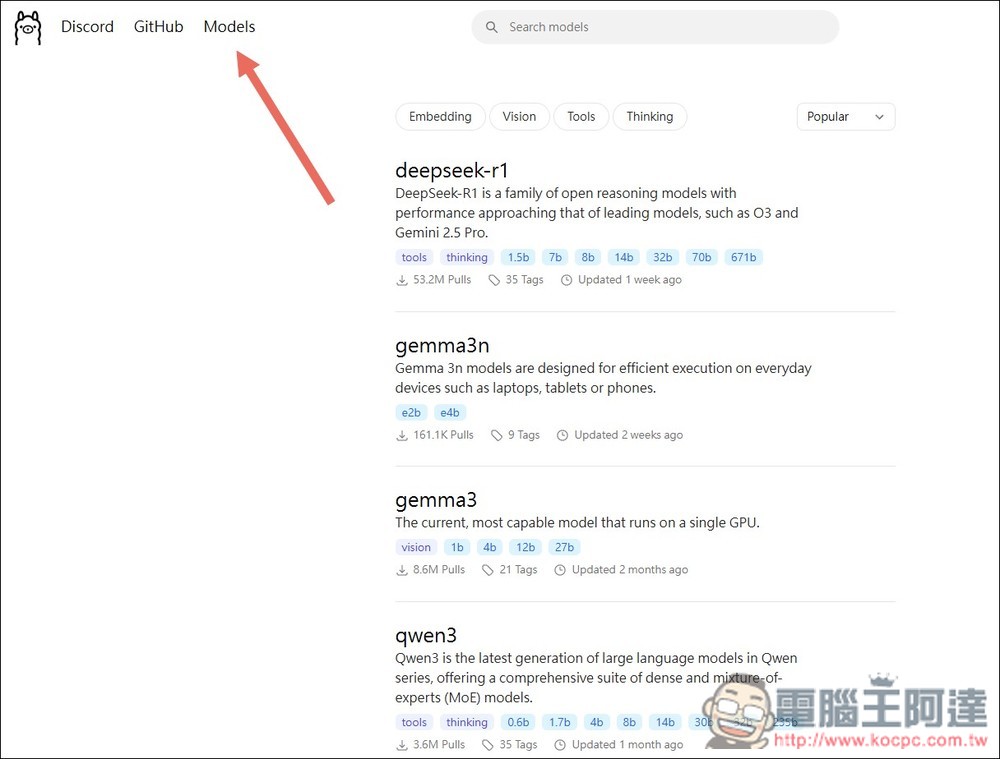

而 Ollama 下載模型的方式也不難,先到官網的模型清單,找到你要使用的模型,我以 qwen3 來說:

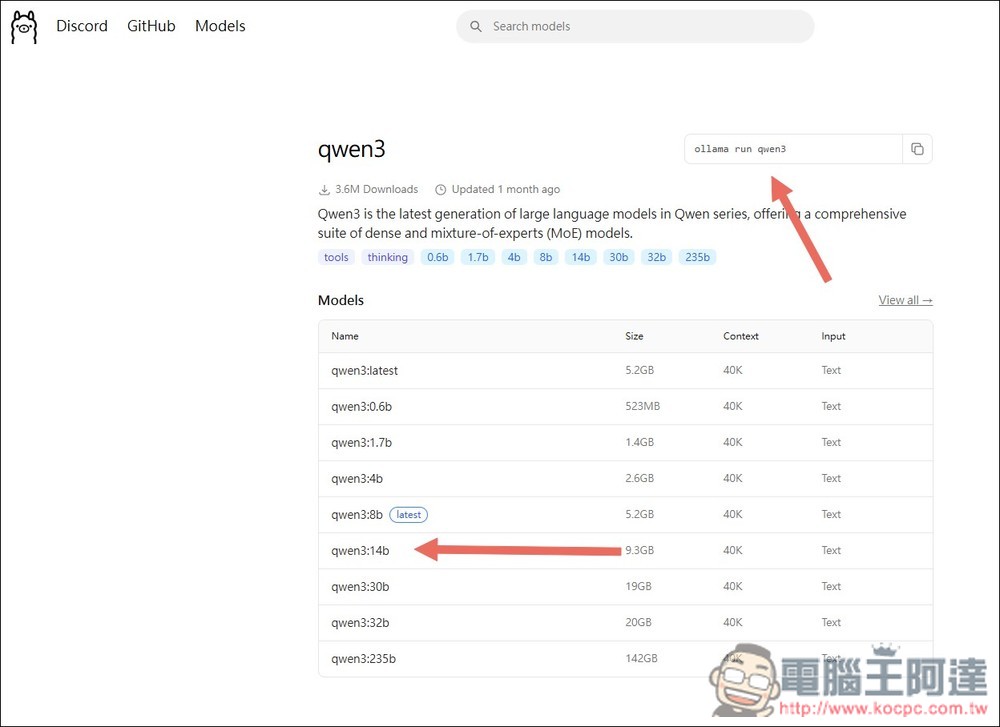

進到內頁後,就會列出所有能下載的 qwen3 模型,我下載 qwen3:14b 這一個,右上方就是 ollama 安裝模型的指令,但我是下載 14b,因此要改成 ollama run qwen3:14b:

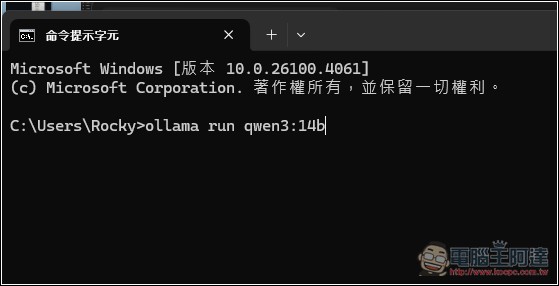

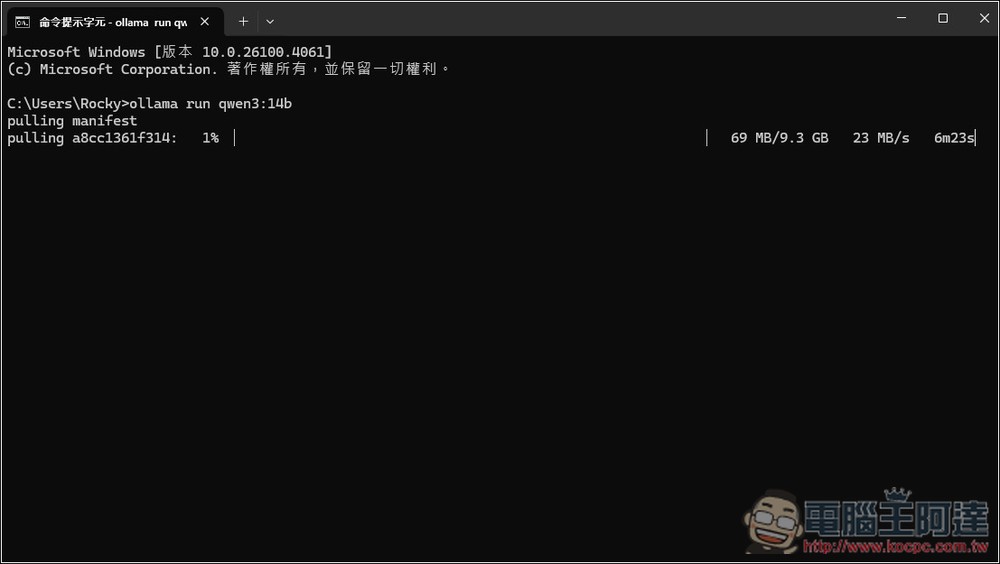

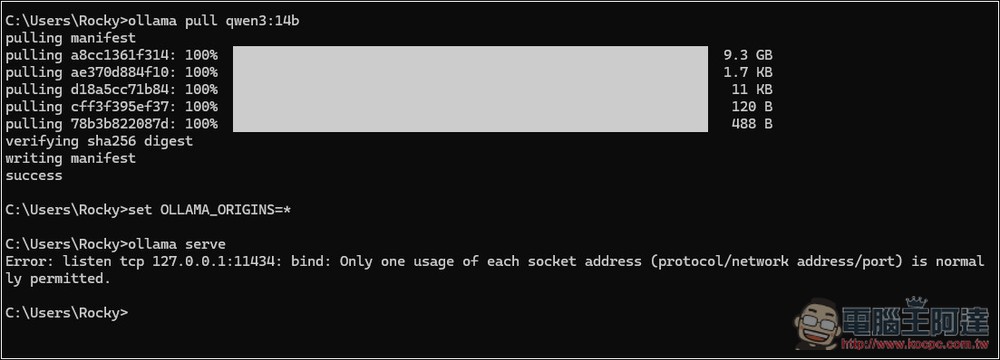

把指令複製起來,打開命令提示字元(Windows)或終端機(Mac),將指令輸入並按下 Enter:

Ollama 就會開始下載,等跑完:

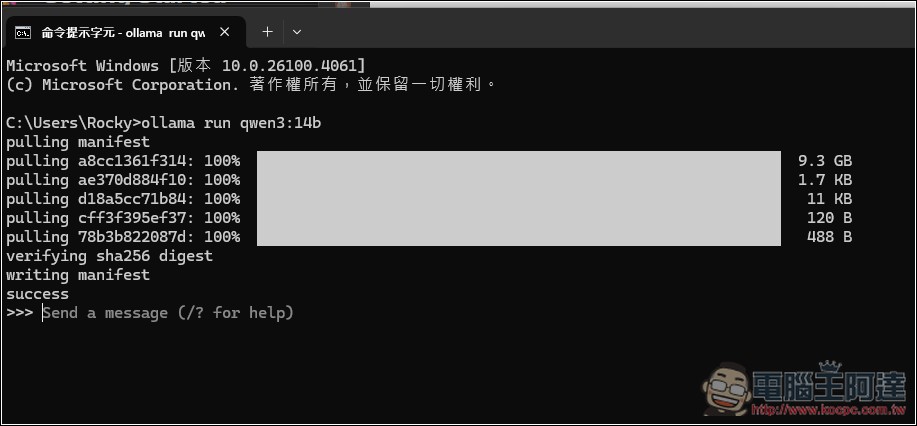

輸入變成 Send a message 就代表下載好了:

回到 BrowserOS 設定頁面,輸入模型名稱,我輸入 qwen3:14b:

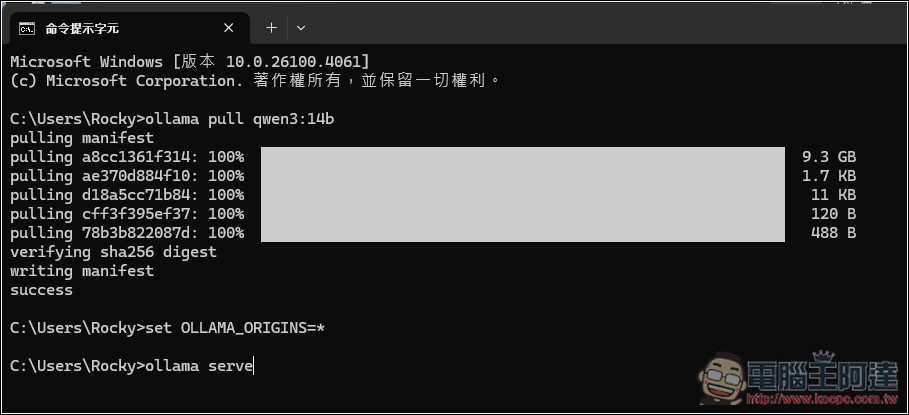

再來再次打開命令提示字元,輸入 ollama pull qwen3:14b (模型名稱記得改成你用的),然後再輸入 set OLLAMA_ORIGINS=*,最後是 ollama serve:

如果你輸入有出現 Error 的錯誤訊息,代表 Ollama 已經在執行狀態,需要先關閉然後再次輸入:

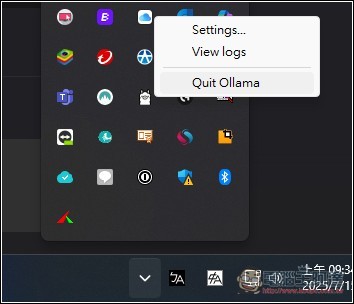

以 Windows 來說,打開右下角選單,找到 Ollama 圖示並打開右鍵選單,按 Quit Ollama:

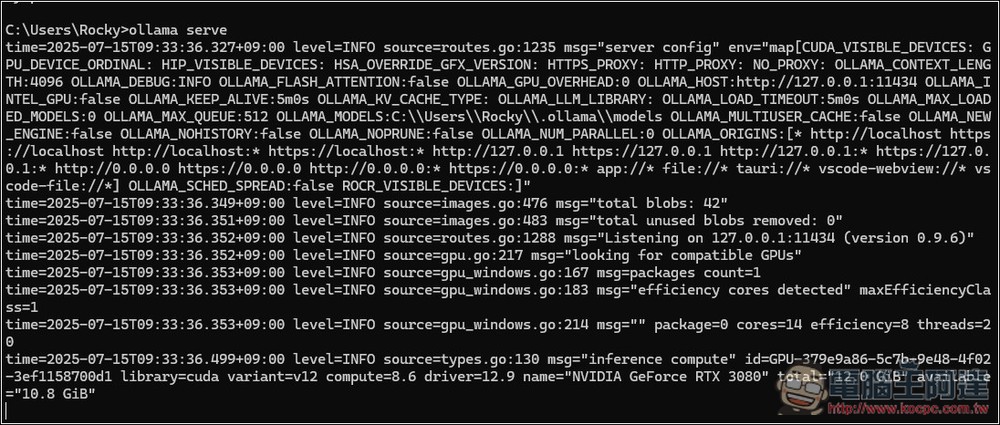

接著再次輸入 ollama serve,出現這一大串字才代表啟用成功:

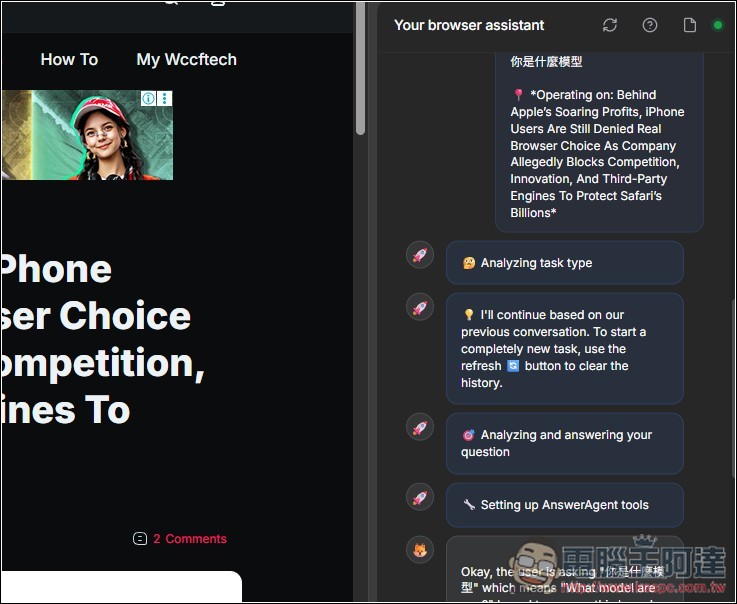

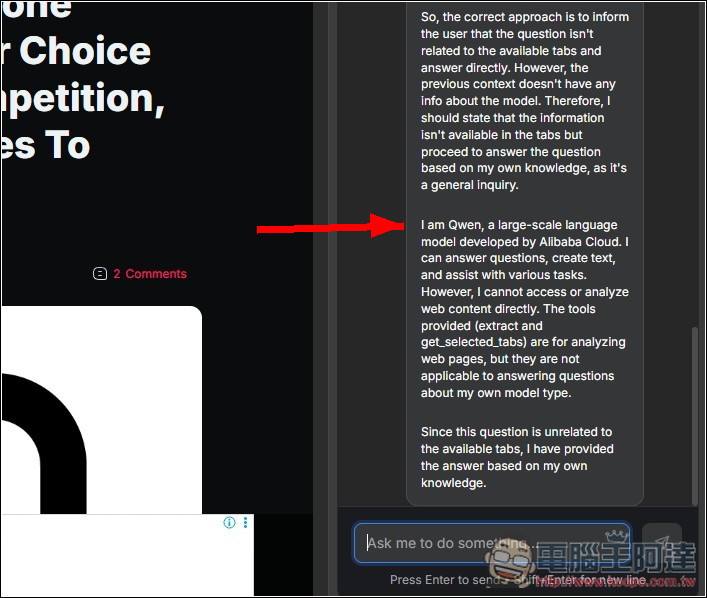

接著回到 BrowserOS 測試,我問 AI 你是什麼模型:

AI 回答我是 Qwen,代表成功: