代理視覺(Agentic Vision)是 Gemini 3 Flash 引入的一項關鍵升級,它讓模型不再只是「看見」影像,而是能基於視覺證據主動推理、操作與驗證,使各類影像任務的準確度大幅提升。這項能力的核心理念,是將視覺理解從被動辨識轉變為「主動調查」,並結合程式碼執行與未來更多工具,讓模型能像人類一樣,以循序探索的方式解決問題。

Gemini 3 Flash 導入全新「代理視覺」(Agentic Vision),可提升影像反應能力

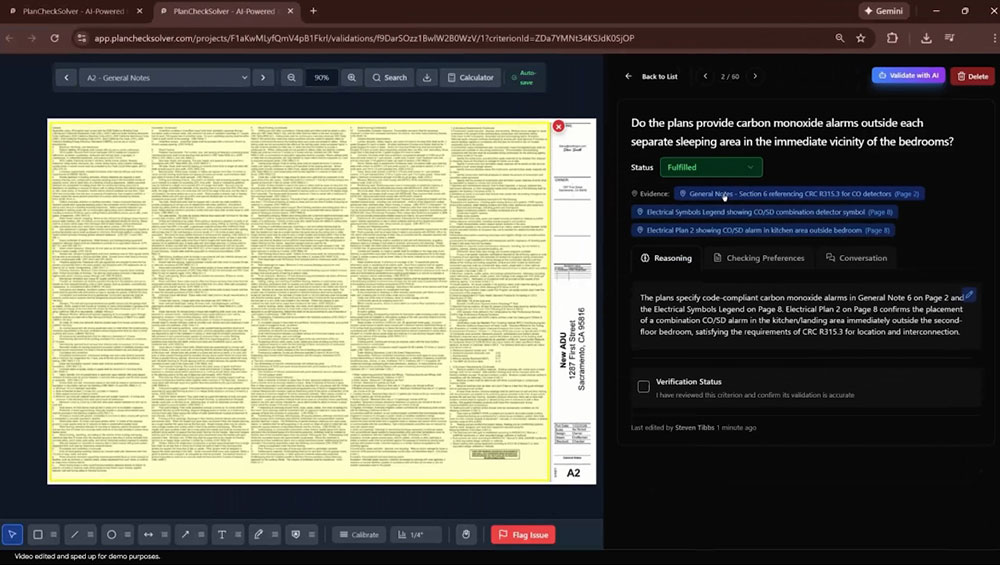

根據 Google 的說法,在這套新方法中,Gemini 3 Flash 會以影像作為互動式資訊來源,並透過「思考、行動、觀察」的循環來完成任務。當使用者提出問題並提供影像時,模型首先會分析查詢內容與初始畫面,推演出一組多步驟的處理計畫。這個階段相當於「思考」:模型會決定需要檢查哪些區域、是否要放大細節、是否需要額外的計算或視覺操作。

接著進入「行動」階段。Gemini 3 Flash 會主動產生並執行 Python 程式碼,直接操作影像本身。例如,它可能裁切特定區域以便更清楚地觀察、旋轉影像以獲得正確方向、在畫面上加上註解,或進行更進階的分析,如計算物件數量、統計邊界框、量測距離等。這些行動不再依賴使用者明確要求,而是由模型根據推理需求自行決定。

完成操作後,模型會進入「觀察」階段。所有經過處理、轉換或標註的影像都會被加入模型的上下文視窗,使其能在更完整的資訊基礎上產生最終回答。這意味著 Gemini 3 Flash 的回應不只是基於原始影像,而是基於一系列由模型自行生成的視覺證據,讓推理過程更透明、結果更可靠。

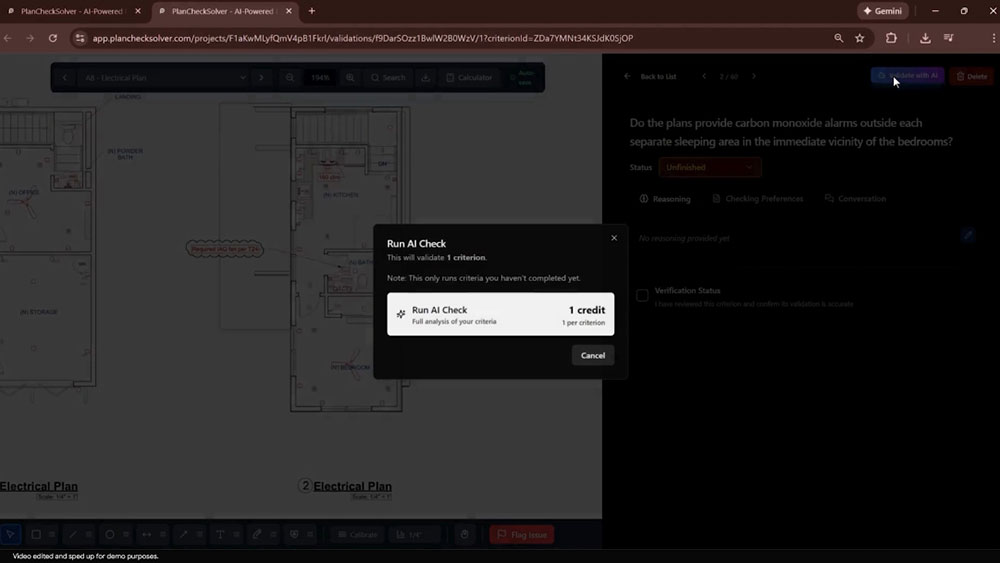

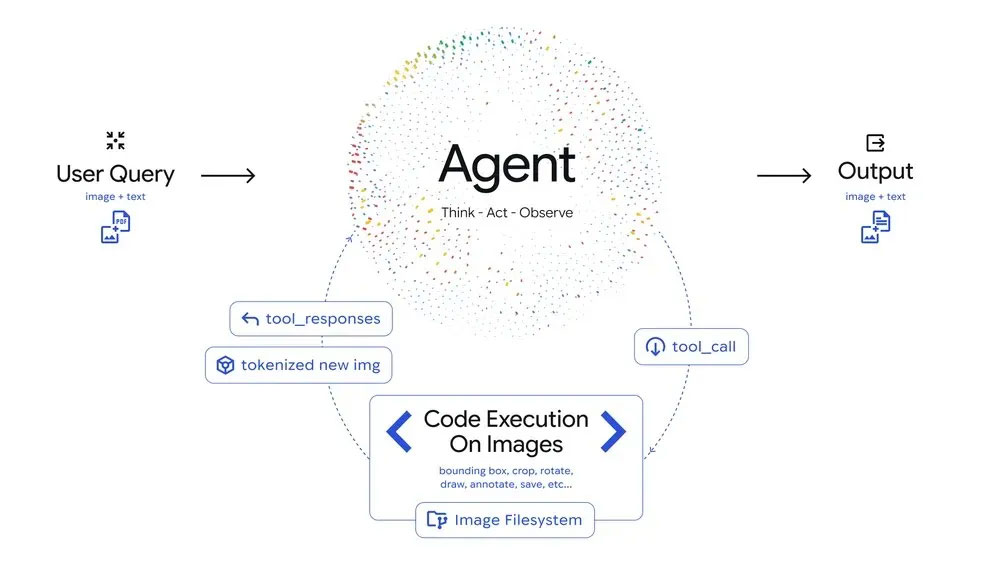

這種能力讓 Gemini 3 Flash 不再只是描述圖片,而是能「在畫布上動手做」,以程式化方式支撐其推理。例如,在 Gemini 應用程式中,模型可以直接在影像上標記手指,逐一數出手上比出的數字,這種互動式註解正是代理視覺的典型應用。除了基本的影像操作,代理視覺也能處理更複雜的視覺資訊。當模型偵測到影像中存在細微或密集的細節時,它會自動放大特定區域,以確保不錯過關鍵訊息。面對高密度的資料表或圖表時,模型甚至能執行 Python 程式碼來解析內容,並以視覺化方式呈現發現,讓資料理解更直觀。

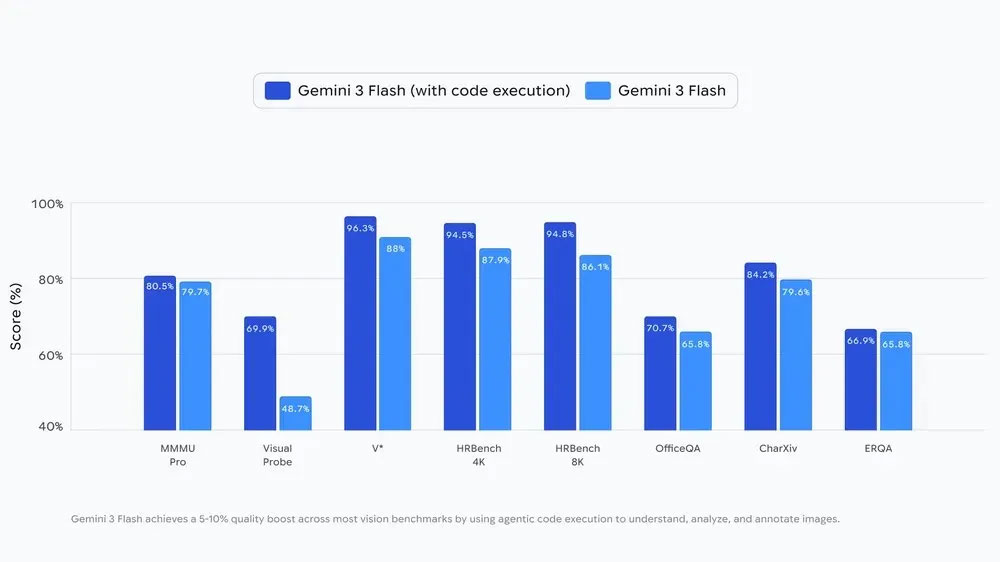

根據官方測試,代理視覺為 Gemini 3 Flash 在多數視覺基準測試中帶來 5% 到 10% 的品質提升,顯示這種主動式視覺推理確實能有效改善模型的整體表現。這項能力目前已逐步推廣到 Gemini 應用程式的 Thinking 模式,並開放給開發者透過 Google AI Studio 與 Vertex AI 的 Gemini API 使用。

展望未來,Gemini 3 Flash 的代理視覺將變得更加成熟。模型將能更精準地旋轉影像、處理視覺數學問題,並且不再需要使用者明確提示才能啟動放大或分析行為。換言之,Agentic Vision 將能自主判斷何時需要更深入的視覺探索。此外,未來的工具將不只限於程式碼執行。Gemini 也將能使用網頁搜尋與反向圖片搜尋,讓模型能以更廣泛的外部資訊補強其視覺理解,進一步提升推理的完整性與可信度。這項能力也預計擴展到其他 Gemini 模型,使整個產品線都能受惠於代理視覺帶來的突破。