隨著人工智慧(AI)應用的迅速擴張,推理(Inference)效能已成為晶片產業兵家必爭之地。根據摩根士丹利(Morgan Stanley)最新研究報告,NVIDIA 憑藉其 Blackwell 架構 GPU 及全棧 AI 軟體優化,於 AI 推論領域中大幅領先競爭對手,不僅在效能上稱霸市場,更帶動用戶獲得遠超業界水準的利潤率。

NVIDIA Blackwell 平台 AI 效能、利潤率全面輾壓對手,AMD表現甚至不如華為

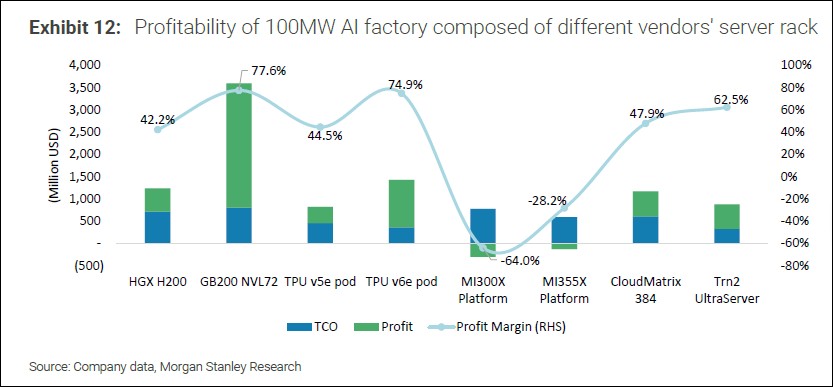

在摩根士丹利針對數個 100 兆瓦等級的 AI 工廠進行的評估中,NVIDIA 的 GB200 NVL72「Blackwell」GPU 平台以高達 77.6% 的利潤率奪得冠軍,預估可產生高達 35 億美元的利潤。緊隨其後的是 Google 的 TPU v6e,利潤率為 74.9%,第三名則是 AWS Trn2 Ultraserver,達到 62.5%。其他廠商(如華為、AMD)的推論解決方案利潤率普遍落在 40% 至 50% 之間,而 AMD 的表現則明顯落後。

報告中特別指出,AMD 的最新 MI355X 平台竟呈現 -28.2% 的負利潤率,代表每運行一小時就會虧損資金;更早期的 MI300X 更是慘跌至 -64.0%。這些數據凸顯 AMD 雖有強大硬體實力,但在 AI 推論領域仍須投入更多軟體優化資源。

以租金換算效能價值:NVIDIA 領先一個世代

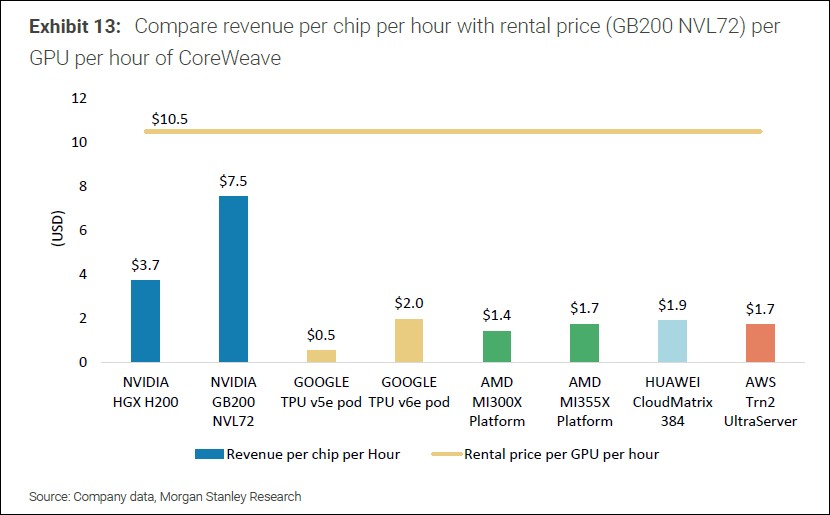

在更具體的晶片收入效能比較上,NVIDIA 的 GB200 NVL72 每小時可產出 7.5 美元營收,遠高於市場平均。第二名為 NVIDIA 的上一代平台 HGX H200,每小時營收為 3.7 美元,而 AMD 的 MI355X 僅為 1.7 美元。其餘平台大多落在 0.5 至 2.0 美元之間,顯示 NVIDIA 的晶片價值已與其他競爭對手拉開一整個世代的差距。

這樣的效能差距不僅體現在晶片架構本身,更來自 NVIDIA 長年累積的 CUDA AI 軟體堆疊(stack)與精密的軟體最佳化策略。摩根士丹利指出,NVIDIA 甚至針對 Hopper 和 Blackwell 等舊型 GPU 定期釋出優化更新,使其效能得以季度性提升,達成所謂「陳年佳釀(Fine Wine)」的產品策略。

硬體成本比較:TCO 相近,效能差異巨大

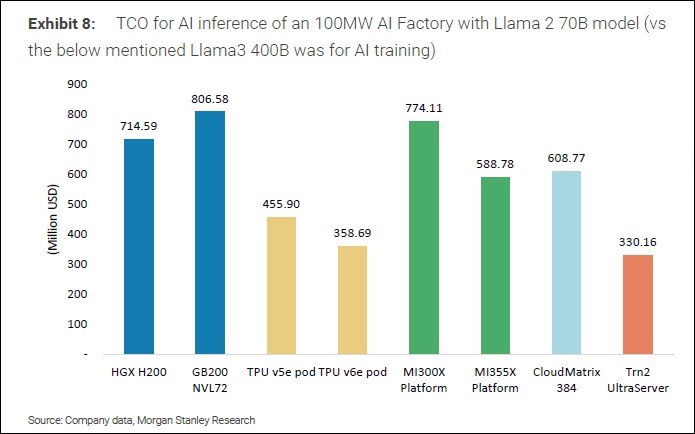

在總體擁有成本(TCO)方面,NVIDIA 的 GB200 與 AMD 的 MI300X 旗鼓相當,分別為 8 億與 7.44 億美元,然而效能與利潤率表現卻呈現天壤之別。至於 AMD 最新的 MI355X 伺服器,其 TCO 為 5.88 億美元,與華為的 CloudMatrix 384 平台相近,但其推論效能仍明顯不敵 NVIDIA。

這顯示,即使在初始投資上 AMD 可與 NVIDIA 持平,最終在 AI 推論環節的報酬率仍遠不及後者。由於 AI 市場約有 85% 應用集中在推論階段,這無疑使 NVIDIA 更具吸引力,也解釋了其在高性能伺服器與雲端 AI 市場的主導地位。

CUDA 軟體生態優勢:NVIDIA 超車關鍵所在

除了硬體架構的優越性,NVIDIA 的主導地位更多來自其全棧 AI 軟體優化策略。其 CUDA、TensorRT、以及 Triton 等軟體堆疊,能在推理過程中持續壓榨硬體極限,且支援最新 FP4 格式,能以極低精度進行 AI 推論任務,大幅降低運算成本,提升效能密度。此外,NVIDIA 長期與雲端業者、超大規模資料中心、以及大型 AI 模型公司合作,打造完整的部署生態系,確保新一代晶片一上線即可獲得應用支援。這種「軟硬整合」的策略,是 AMD 和其他業者目前仍無法完全複製的優勢。

為保持技術優勢,NVIDIA 與 AMD 都採取年度迭代節奏,積極推進新架構研發。NVIDIA 預計在 2025 年內推出 Blackwell Ultra,效能將比 GB200 再提升 50%。2026 年上半年,下一代 Rubin 架構將正式量產,後續還有 Rubin Ultra 與 Feynman 計畫排隊中。

AMD 則計畫於 2025 年推出 MI400 系列,對標 NVIDIA 的 Rubin。市場預期 AMD 將於此系列進行更深入的 AI 推論最佳化工作,雖仍處於追趕階段,但已展現對市場競爭的高度重視,但市場接受度仍須看其真實表現。

結論:NVIDIA買越多省越多

根據摩根士丹利分析,未來數年內,AI 市場的 85% 商業價值將來自推論環節,而非訓練階段。因此,推論效能與營運效率,將成為企業選擇晶片平台的首要考量。在這場以 AI 推論為核心的競爭中,NVIDIA 結合高效能硬體與深厚軟體實力,已成為「AI 工廠」中最具利潤價值的選擇。相較之下,儘管 AMD 在硬體規格上已大幅進步,但缺乏成熟的軟體堆疊與生態系整合,使其仍難以與 NVIDIA 抗衡。