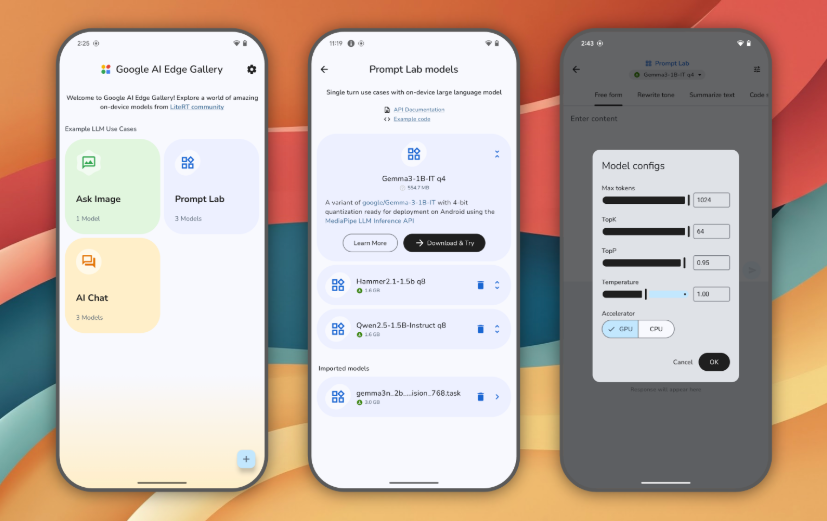

除了電腦,手機本地運行 AI 模型也開始快速發展,Google 就針對 Android 推出一個全新的 Google AI Edge Gallery 免費工具,讓用戶能在本地運行自家 Google 開源模型 Gemma 系列(iOS 版也快推出),而且不只是單純的文字對談,也有支援多模態模型,可以上傳圖片或拍照讓 AI 辨識來獲得你想要的答案,我快速測試一下,運行速度也還可以接受,可指定要用 CPU 或 GPU 來運行,下面就來教你怎麼安裝使用。

圖片來源:GitHub

Google AI Edge Gallery 安裝教學,實現 Android 本地運行 Gemma 系列模型

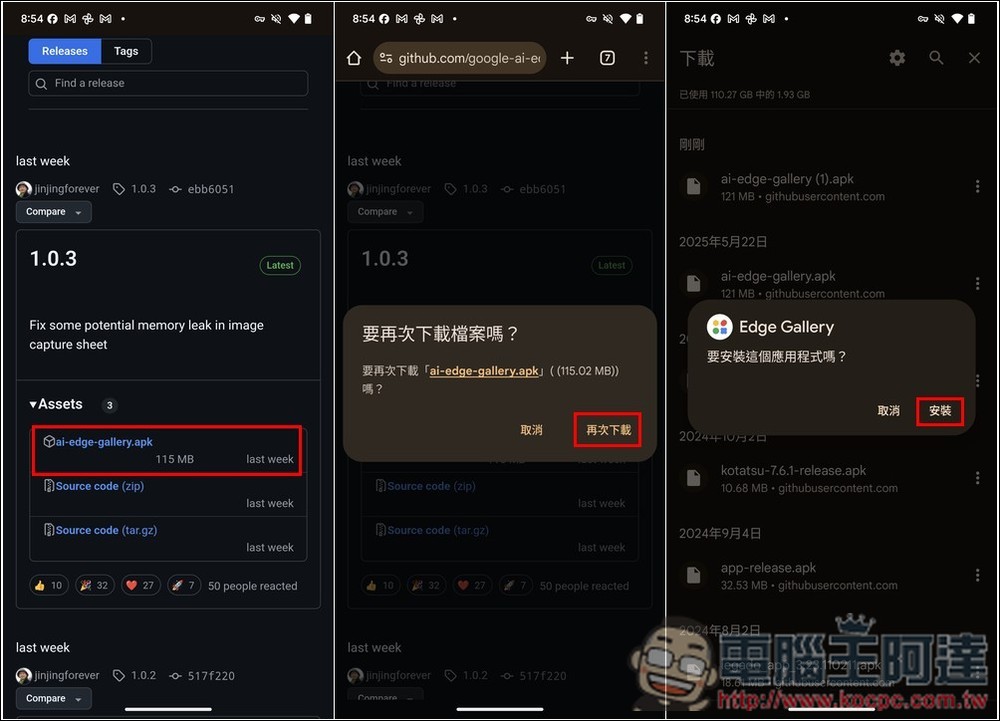

Google AI Edge Gallery 目前還是實驗性應用程式,因此沒在 Google Play 商店上架,要到 GitHub 開源專案手動下載 APK 檔安裝。另外使用時,你也會需要 Hugging Face 的帳號(下載模型需要登入),沒有的人就免費註冊一下。

相較於線上版,本地使用 AI 有很多好處,像是你不用擔心資料被服務商拿去訓練或使用、沒有網路的情況下,你也能繼續用 AI,這對出國來說非常有幫助,像是你碰到不懂的菜單,就能將菜單拍下來,傳給 AI 辨識並翻譯。

按上方連結進到 GitHub 專案後,目前最新版是 1.0.3,下載 .apk 檔案,下載好後就打開並安裝(我之前有下載過了,才會跳出再次下載的詢問訊息):

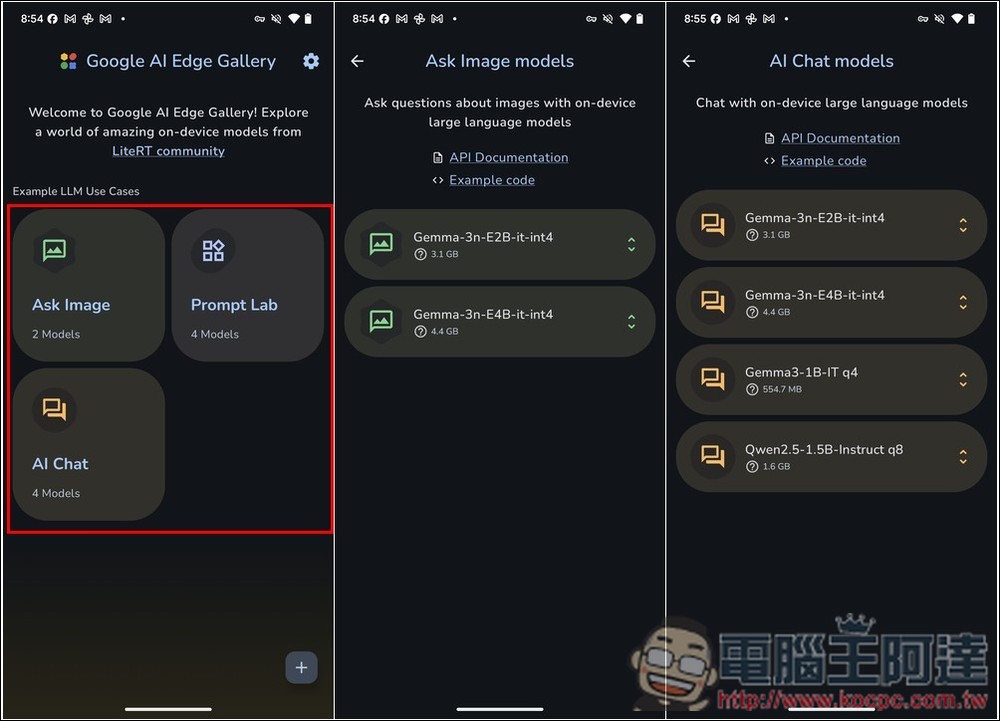

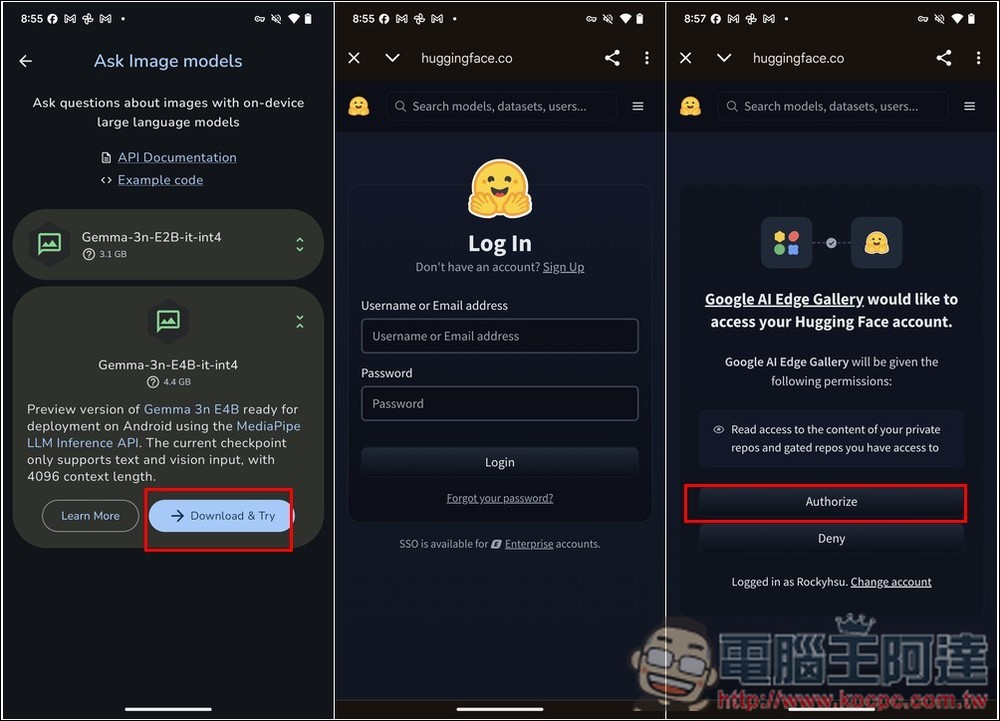

打開 Google AI Edge Gallery 後,會有三種模式,Ask Image、AI Chat 和 Prompt Lab,如果你要圖片辨識,就進到 Ask Image,裡面會顯示符合的模型,目前支援多模態的有 Gemma-3n-E2B 和 Gemma-3n-E4B 這二個,文字聊天的話有四個,除了前面二個外,還有 Gemma3-1B 和 Qwen 2.5-1.5B:

找到你想用的模型後,首次下載需要登入你的 Hugging Face 帳號:

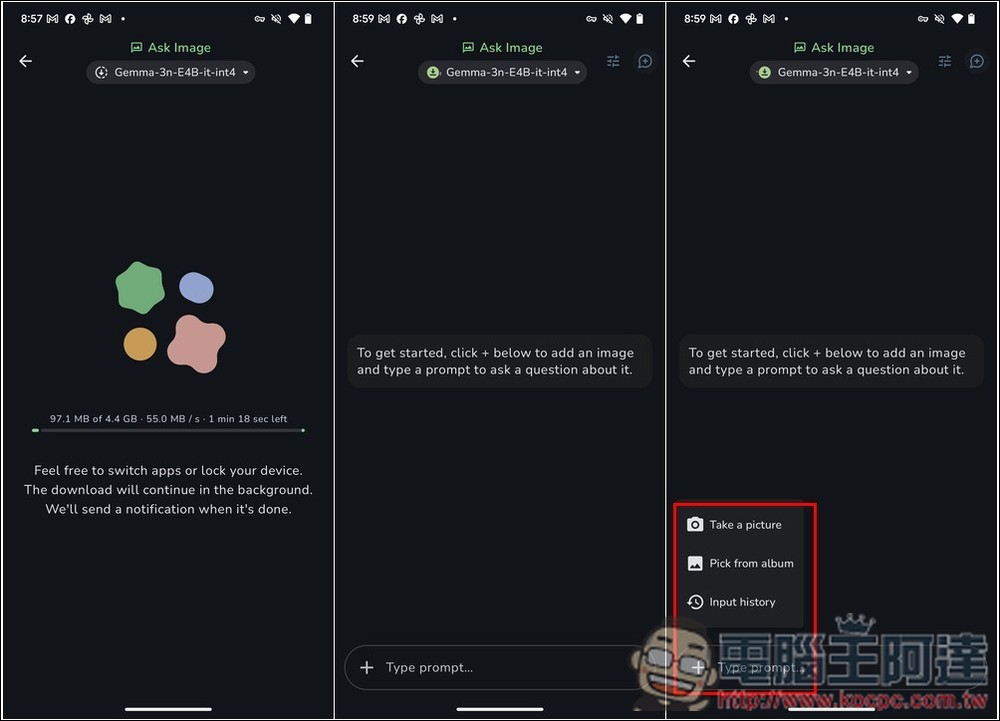

接著就會開始下載,完成後,即可開始跟 AI 對談,按左側的 + 可添加圖片或拍照:

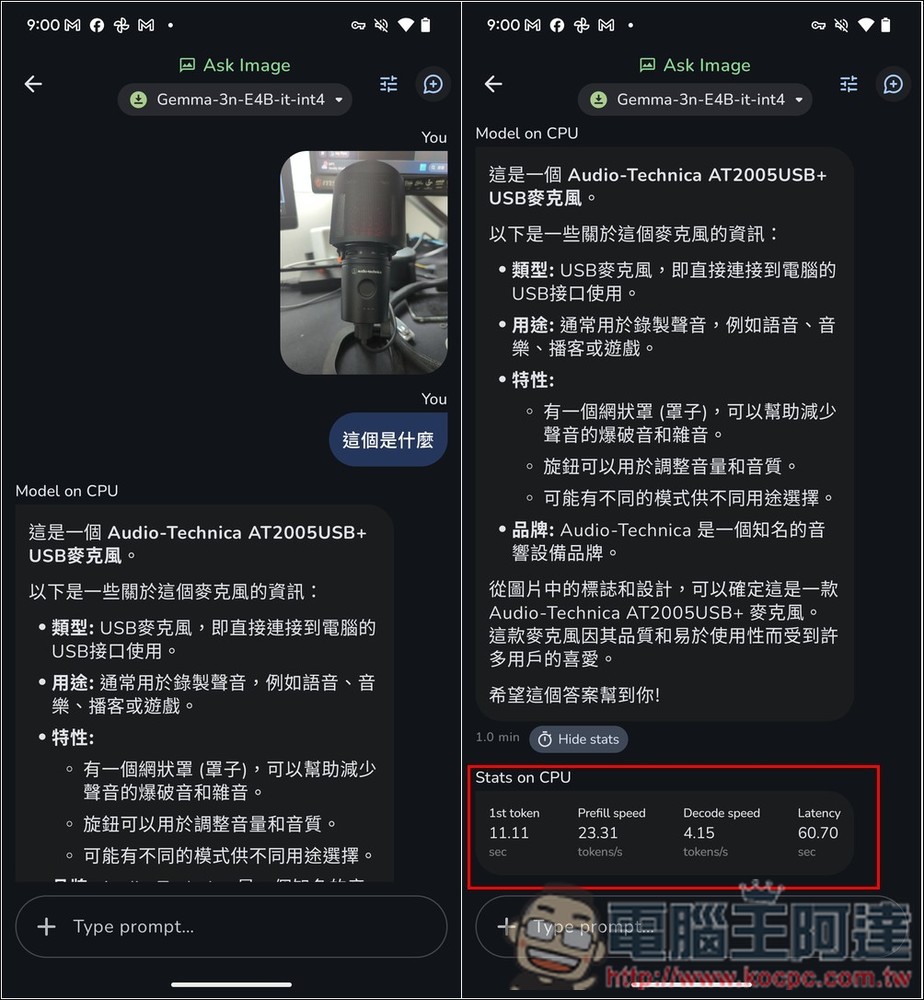

我先測試拍照,用手機拍我前面的麥克風後問它 “這個是什麼”,雖然品牌辨識正確,但麥克風型號是錯的,畢竟只是 3n 模型,訓練數據沒這麼大,辨識產品型號對它來說還是有難度,但至少產品是什麼沒說錯。回覆完之後,底部會顯示速度、Tokens 等資訊,預設會使用 CPU 來運算:

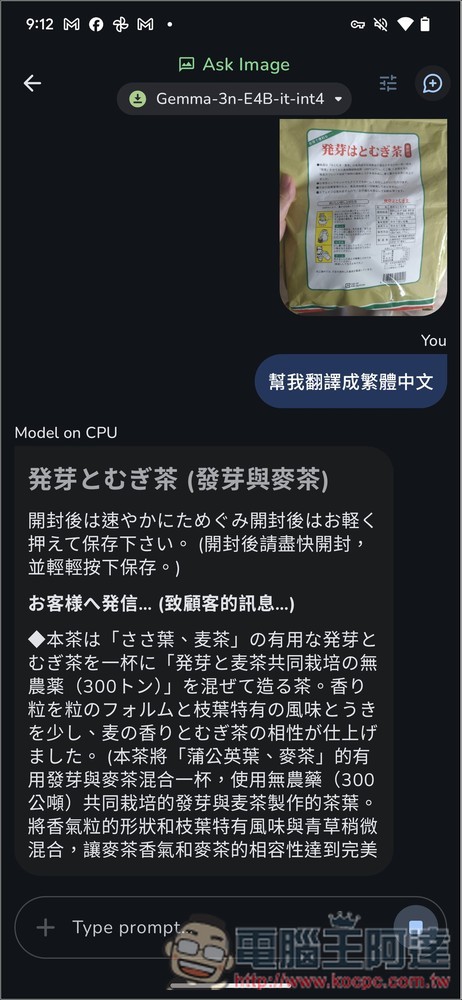

再來我測試翻譯,這部分就沒問題,雖然某些內容還是翻譯怪怪,但至少看得懂:

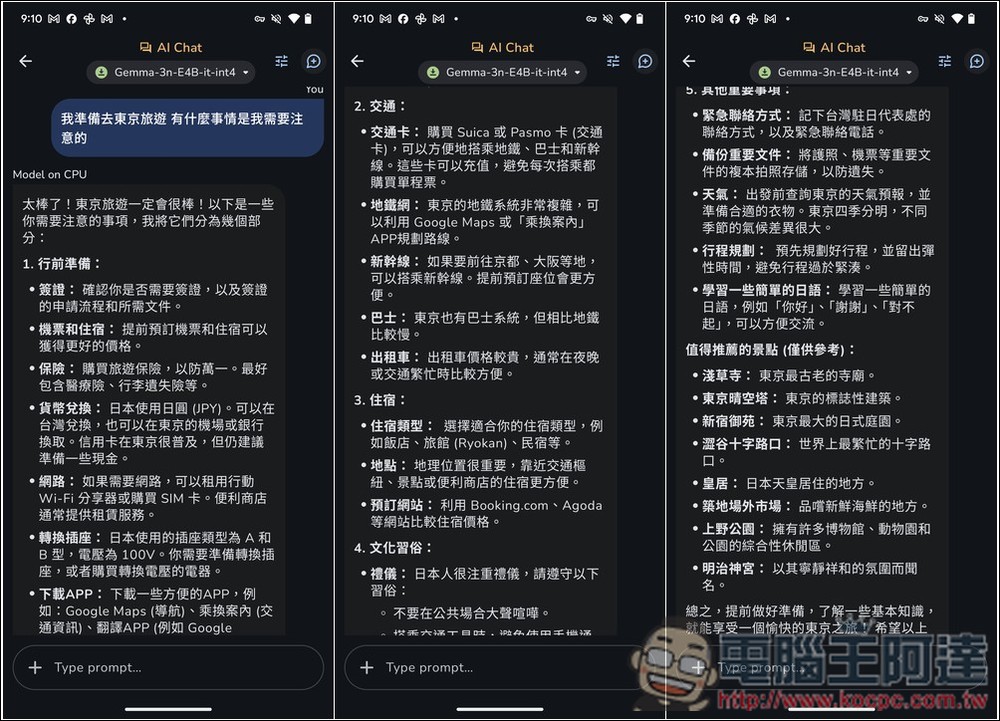

文字部分回應的長度讓我有嚇到,我單純問 “我準備去東京旅遊,有什麼事情是我需要注意的”,Gemma-3n-E4B 回應一大串,各方面都有,從行前準備、交通、其他重要事項、到值得推薦景點等都有,由此可見就算是小模型,回覆的豐富度也是很不錯:

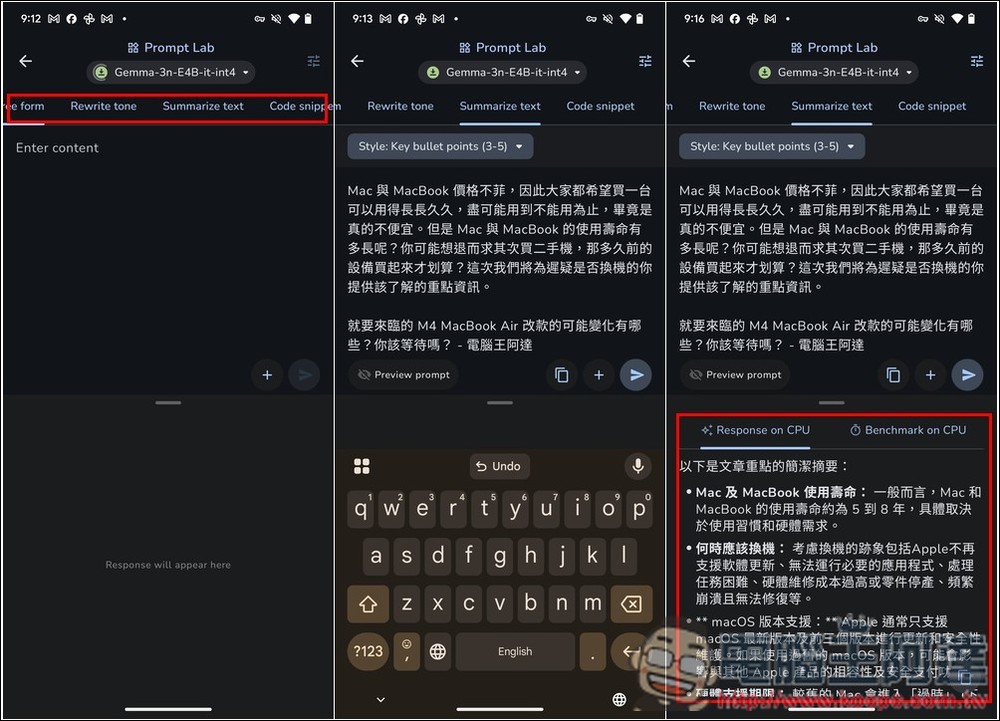

Prompt Lab 則是內建的幾個常用模式,如:重寫語調、摘要等,把內容填入後按下送出,就會開始執行。我測試摘要成功,不過速度會慢一點,AI 需要先閱讀全部,接著才會輸出:

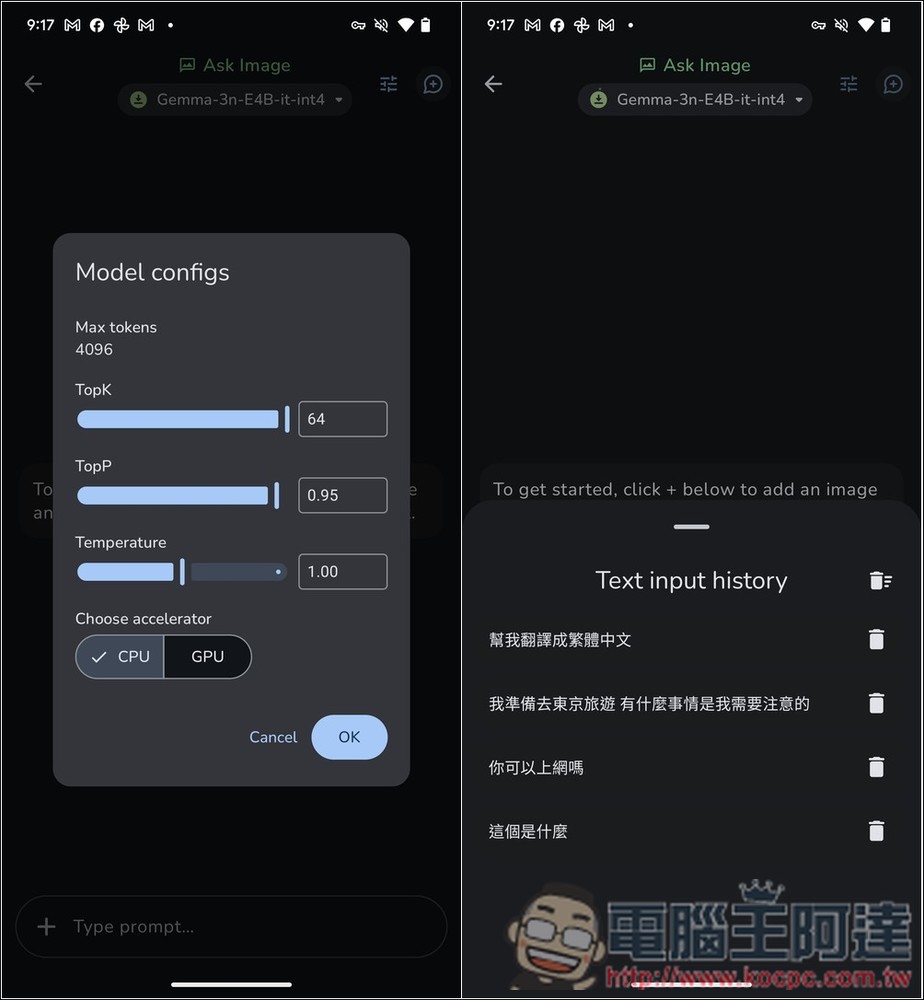

按右上角三條線圖示,可以調整最大 Tokens 以及 CPU 或 GPU 運算。而 + 號的 input history 會顯示過去你曾經使用過的提示詞,方便你重複使用: