在人工智慧(AI)技術不斷推進參數量規模(Scaling law)的當下,訓練大型語言模型(LLM)所需的龐大資料量與高昂成本,長期以來一直是技術落地與快速迭代的最大瓶頸。Google 近日公布一項突破性研究成果,聲稱其研發的新型資料篩選與標註流程,能在維持模型精度的同時,將訓練所需的高忠實度(high-fidelity)資料量削減至原本的萬分之一。

從數百億參數到資料瓶頸:LLM訓練的困境

隨著 AI 模型規模持續擴大,最新一代 LLM 的參數量已達數百億甚至數千億級別。雖然規模擴張帶來了推理能力與多任務適應性的提升,但同時也帶來了資料需求的爆炸性增長。傳統上,要讓模型在複雜且具文化背景差異的任務中表現穩定,需要大量人工精確標註的訓練資料。

以廣告安全審查為例,如何從龐大的廣告庫中識別出不安全或違反政策的內容,不僅涉及語義判斷,還需考慮文化語境與地區規範差異。這類高複雜度任務往往需要「高忠實度」的訓練數據──也就是由專業人士審核並標註的數據。然而,專業標註的時間成本與金錢成本極高,且隨著政策更新或新型態內容出現,模型可能需要完全重新訓練,進一步拉高成本。

Google的新策略:資料選擇的閉環式優化

面對這一挑戰,Google 將「在不降低標註品質的前提下,大幅減少所需訓練資料量」列為首要目標,並提出了一套全新的資料篩選循環流程(curation process)。

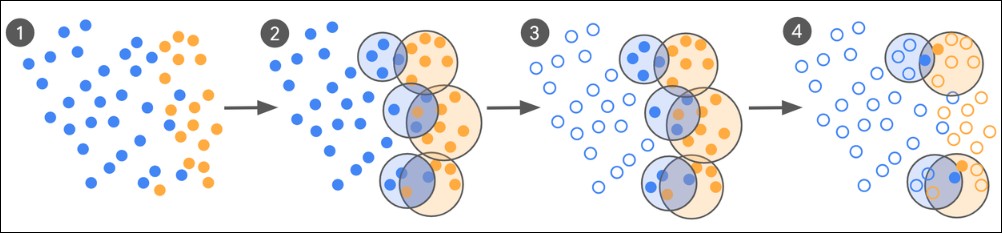

這一流程以人類專業知識為核心,結合模型自身的初步分類能力,採取「先粗後精」的閉環式優化方式:

-

少樣本啟動

以零樣本或少樣本(few-shot)方式,先讓模型根據既有標籤(例如「安全廣告」與「不安全廣告」)進行初步分類。 -

識別邊界樣本

模型在大多數案例中能做出明確判斷,但會出現一部分「邊界樣本」,即模型判斷模糊或可能出錯的案例。 -

專家標註邊界樣本

這些邊界樣本被送交人類專家進行精確標註。由於標註範圍僅限於高不確定性案例,所需的人工標註量遠低於全量數據。 -

模型再訓練與循環迭代

將專家標註結果重新用於模型微調,並重複上述流程,直到性能提升趨於穩定。

這種方法的關鍵在於將專家資源集中投入在最具爭議性、最能影響模型判斷的案例,避免在大量容易分類的樣本上浪費人力。

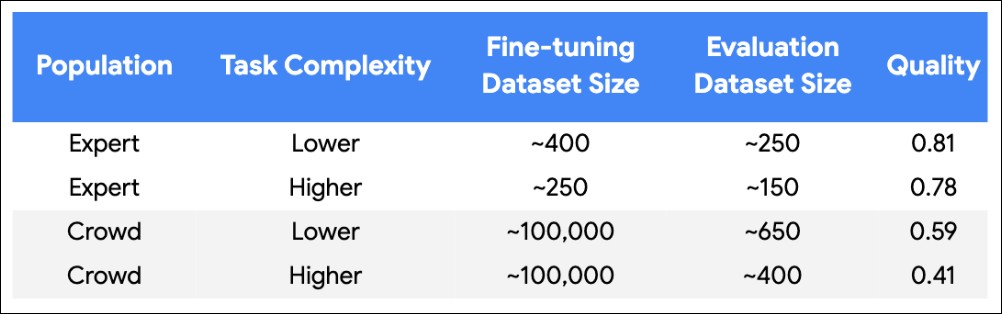

實驗數據:從10萬筆到500筆的跨越

Google 在實驗中使用了兩個不同規模的 LLM:參數量 18 億的 Gemini Nano-1 與 32.5 億的 Gemini Nano-2,針對不同複雜度的廣告安全分類任務進行測試。每個任務的資料集約包含 10 萬筆廣告,其中約 95% 被標記為無害。

透過新流程,Google 將需要專家標註的數據量從 10 萬筆 驟降至 500 筆以內,同時實現以下成果:

-

Gemini Nano-1(小型模型)

在資料大幅減少的情況下,性能與使用全量數據訓練的結果幾乎持平。 -

Gemini Nano-2(大型模型)

當訓練數據量削減至原本的 1/1000 到 1/10000 時,準確率反而提升了 55%~65%。

這一結果顯示,對於特定任務而言,「精挑細選的少量高品質資料」可能比「海量但品質參差的資料」更具價值。

標註品質的關鍵:Kappa > 0.8

Google 強調,這一方法的成功並非僅依賴資料選擇策略,高品質標註本身是不可或缺的基礎。在這些廣告安全審查任務中,若要讓模型表現超過眾包工作者(crowd workers)標註的水準,必須確保標註一致度(以 Kappa 值 衡量)超過 0.8。這意味著專家之間的判斷須高度一致,才能成為有效訓練資料。

透過結合 LLM 對大範圍內容的初步分類能力與專家對高難度案例的精確判斷,Google 認為能夠更靈活地運用高忠實度標註資料,突破資料瓶頸。

對產業的啟示:資料效率時代的到來

Google 的研究為 AI 模型訓練帶來了兩項重要啟示:

-

效率優先於規模

在特定情境下,優化資料選擇與標註流程,比一味追求資料量更能帶來性能提升。 -

專家與模型的協作價值

LLM 能快速處理與篩選大範圍資料,但在高不確定性案例中,仍需仰賴人類專業知識。這種人機協作模式,或將成為未來 AI 訓練的標準方法論。

在廣告安全、醫療診斷、內容審查等高風險應用領域,這種方法尤其具吸引力,因為它能顯著降低數據採集與標註成本,並縮短模型迭代週期。

面對 AI 技術與應用場景的快速變化,Google 的這項成果顯示,未來的競爭不僅是比拼模型規模與運算能力,更是資料管理與標註策略的較量。當資料效率成為新一輪技術革新的關鍵詞,誰能以更少的資料達到更高的性能,誰就有機會在 AI 競賽中脫穎而出。