人工智慧與高效能運算領域再次迎來重大突破。全球繪圖處理器與人工智慧運算巨頭 NVIDIA,於 2025 年 8 月 18 日正式發佈了其新一代小型開放式語言模型:「Nemotron Nano 2」。此模型最大的亮點在於其創新的混合推理架構,成功將業界主流的 Transformer 與新興的 Mamba 狀態空間模型(State Space Model, SSM)相結合,旨在解決傳統模型在處理長序列時面臨的記憶體與計算成本高昂的難題,並在保持高精度的同時,實現了數倍於同級別模型的推論吞吐量。

技術核心:Transformer 與 Mamba 的強強聯合

Nemotron Nano 2 並非從零開始的全新設計,而是基於 NVIDIA 內部代號為「Nemotron-H」的混合架構模型。要理解其革命性,必須先了解其兩大技術支柱的背景與優劣。

-

Transformer 架構:當今主流之基石與瓶頸

自 2017 年由 Google 團隊提出後,Transformer 架構已成為幾乎所有大型語言模型(如 GPT、PaLM、Llama 等)的基礎。其核心的「自注意力機制」(Self-Attention Mechanism)使模型能夠同時權衡輸入序列中所有字詞的重要性,從而卓越地理解上下文語意關聯。然而,其致命弱點在於,自注意力機制的計算複雜度會隨著序列長度(n)呈二次方(O(n²))增長。這意味著當處理長篇文章、程式碼庫或長時間對話等長序列任務時,模型所需的記憶體和計算資源會急遽暴增,成為推論效率與部署成本的巨大阻礙。

-

Mamba 架構:效率新星的崛起

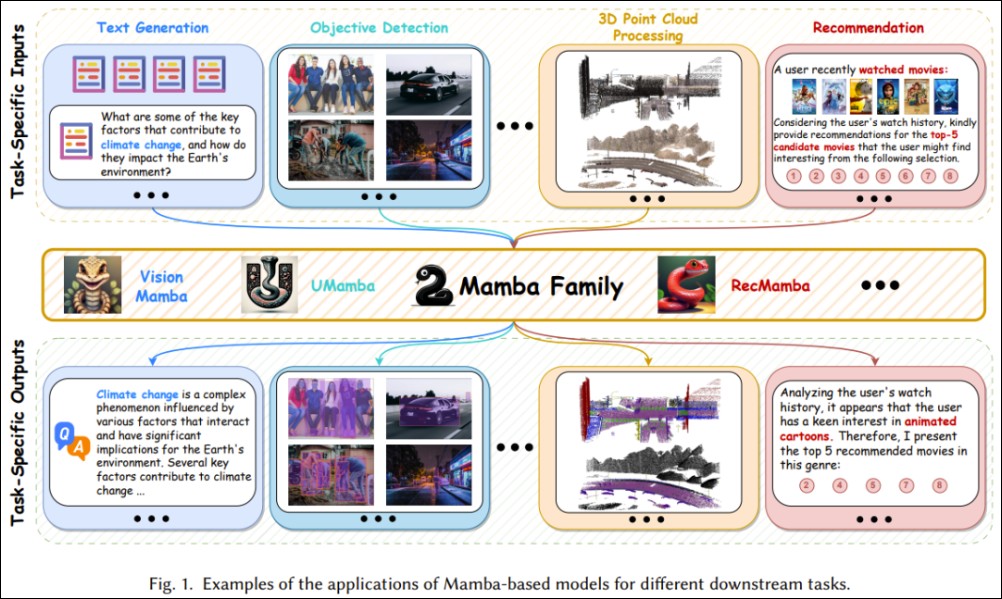

為了解決 Transformer 的瓶頸,學術界與產業界不斷尋求替代方案。於 2023 年 12 月發表的 Mamba 架構便是其中的佼佼者。它屬於狀態空間模型(SSM)家族,透過一種名為「選擇性狀態空間」(selective state spaces)的機制,能夠動態地選擇性地關注或忽略輸入資訊中的不同部分。其最大優勢在於,計算複雜度僅與序列長度呈線性關係(O(n))。這使得 Mamba 在處理極長序列時,能夠顯著降低對記憶體和計算資源的需求,同時保持甚至在某些任務上超越 Transformer 的性能。

Nemotron-H 的混合策略正是將兩者的優勢互補。NVIDIA 的研究團隊巧妙地設計了模型架構,讓 Transformer 模組負責處理需要高度上下文理解的核心任務,而 Mamba 模組則高效地處理長序列的依賴關係。這種混合模式宣稱能夠在「長上下文」情境下,達成更高的吞吐量(Throughput)和同等的精度(Accuracy)。

模型規格與開放生態

NVIDIA 此次並未僅僅發佈單一模型,而是提供了一個完整的模型家族,並透過 Hugging Face 平台開放給開發者社群:

-

Nemotron-Nano-12B-v2-Base:擁有 120 億參數的「修剪前」基礎預訓練模型,供研究人員進行深度分析與進一步微調。 -

Nemotron-Nano-9B-v2-Base:經過修剪(pruned)後的 90 億參數基礎模型,參數更精簡,效率更高。 -

Nemotron-Nano-9B-v2:最終的對齊(aligned)與修剪模型,專為下游應用優化,也是此次效能比較的主角。

特別值得一提的是,Nemotron-Nano-9B-v2 經過高度優化,僅需單一顆 NVIDIA A10G GPU 即可流暢運行。這大幅降低了企業與開發者的部署門檻,使得高性能的私有化模型部署成為可能,無需依賴昂貴的雲端 API 或龐大的 GPU 叢集。

效能實測:全面碾壓同級競品

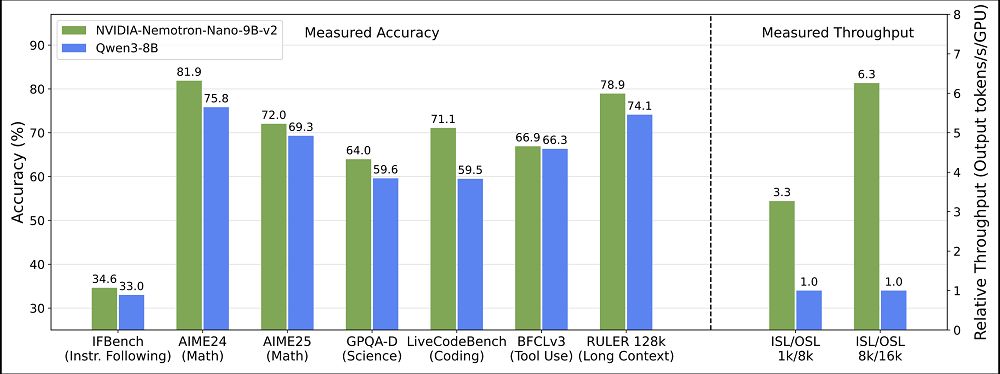

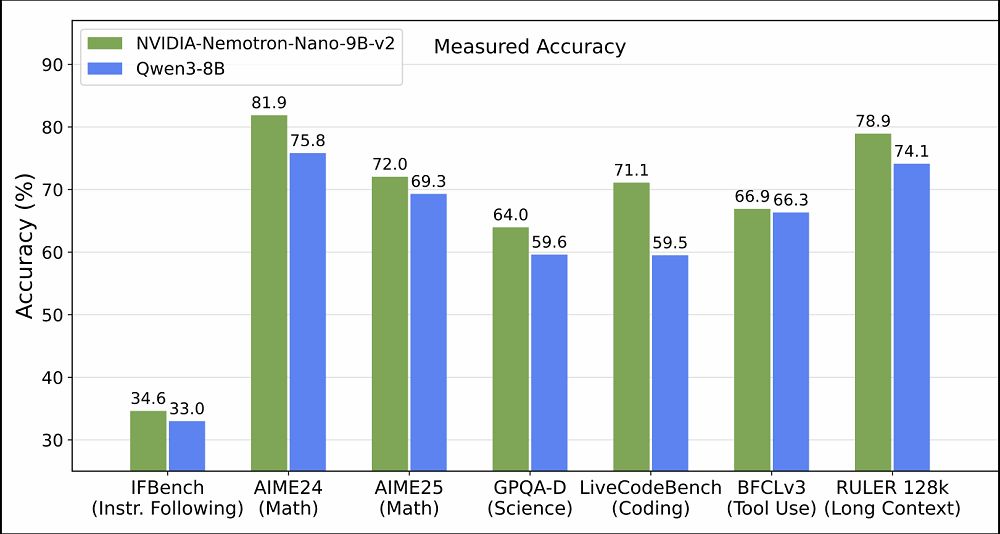

NVIDIA 在官方報告中,將 Nemotron-Nano-9B-v2 與當前同規模(約 80 億參數)的開源模型標竿:阿里巴巴的通義 Qwen3-8B 進行了全面對比。結果顯示,Nemotron 不僅在精度上與之持平甚至超越,更在效率上展現出壓倒性優勢。

1. 精度比拚(Accuracy)

在涵蓋數學(如 GSM8K)、科學(如 MMLU)、程式編碼(如 HumanEval)等多項複雜推理的標準學術基準測試中,Nemotron-Nano-9B-v2(圖中綠色長條)在大多數項目上都取得了優於 Qwen3-8B(藍色長條)的成績。這證明了混合架構在維持模型「智慧」與「能力」方面同樣出色,並未因追求效率而犧牲性能。

2. 吞吐量決戰(Throughput)

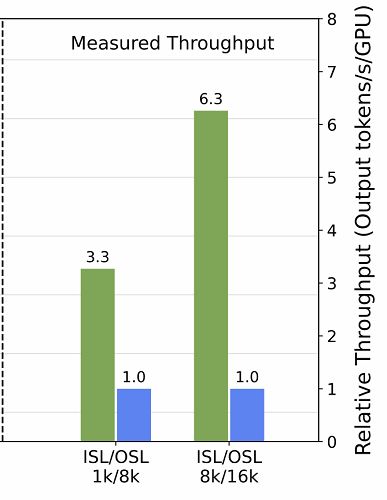

這才是 Nemotron Nano 2 的真正殺手鐧。下圖展示了在不同輸入序列長度(ISL)和輸出序列長度(OSL)下,兩模型的吞吐量(tokens/秒)表現。

圖表清晰顯示,Nemotron-Nano-9B-v2 的吞吐量最高可達 Qwen3-8B 的 6 倍之多。更關鍵的是,隨著處理的序列長度增加,兩者之間的效能差距會急遽擴大。這完美印證了 Mamba 架構在處理長序列時的線性效率優勢,對於需要處理長文件摘要、長對話歷史聊天機器人或長程式碼生成等實際應用場景,意義極為重大。

授權與商用條款:擁抱開源與商業化

Nemotron Nano 2 系列模型採用的是 NVIDIA 自行制定的 「NVIDIA Open Model License」。此授權條款對開發者與企業相當友好:

-

允許商用:開發者可自由將模型用於商業目的,整合至自家的產品與服務中。

-

允許修改與分發:開發者可以基於 Nemotron Nano 2 創建並分發自己的衍生模型。

當然,使用者也需遵守一些基本義務,例如:在沒有適當防護措施的情況下,不得刻意繞過內建的安全機制(以避免模型被惡意濫用),以及在再分發時必須保留原始的版權標示與授權聲明。總體而言,這是一個鼓勵創新與商業化的開放性授權。

產業意義與未來展望

NVIDIA 此次發佈 Nemotron Nano 2,傳遞出幾個強烈訊號:

-

效率優先的時代來臨:在追求「更大參數量」的軍備競賽之外,「更高效率」已成為另一個核心賽道。如何用更少的資源做更多的事,是模型真正實現普及與落地應用的關鍵。

-

混合架構成為新趨勢:Nemotron-H 證明,未來的模型設計不必是非此即彼的選擇。融合不同架構的優勢,取長補短,將成為下一代模型創新的主要方向。

-

邊緣運算AI的推進:能夠在單張消費級企業GPU(如A10G)上高效運行的高性能模型,將極大地加速AI在邊緣裝置、本地伺服器上的部署,滿足資料隱私、低延遲和成本控制的需求。

結語

NVIDIA Nemotron Nano 2 的問世,不僅僅是一款新模型的發佈,更是對大型語言模型未來發展方向的一次重要示範。它成功地展示了混合架構的巨大潛力,在精度與效率之間找到了優雅的平衡點。對於整個AI開源社群和企業界而言,這無疑注入了一劑強心針,預示著更高效、更易得、更強大的AI工具即將到來,並進一步推動生成式AI技術在各行各業的深度整合與創新應用。