隨著生成式 AI 如 ChatGPT、Gemini、Grok 等大語言模型服務在全球大受歡迎,它們所帶來的能源與環境議題正逐漸浮上檯面。每一次輸入一個問題並獲得答案,背後其實是遠在全球某處超大型數據中心進行龐大計算與各種冷卻系統維持。這些過程不但會消耗大量電力,並伴隨珍貴水資源的使用,之前 MIT 對能耗使用的報告就相當驚人。近期,Google 公布了一份針對自家 AI 模型 Gemini 的詳細能源報告,揭示了其每次回答使用者問題時的電力消耗、碳排放與水資源使用的具體數據,但結果似乎沒有外界想的那麼誇張。

技術帶來進步,AI能力與能源效率的反比成長

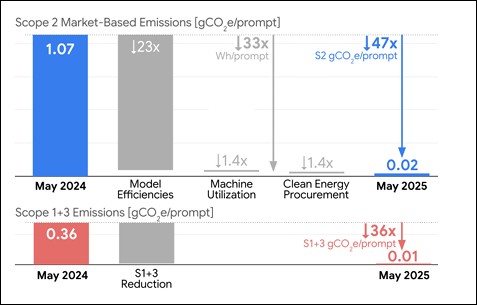

Google指出,僅在過去一年內由模型的優化與各種調整,Gemini模型的能耗已縮減至原先的33分之一,碳排放量更降至44分之一。

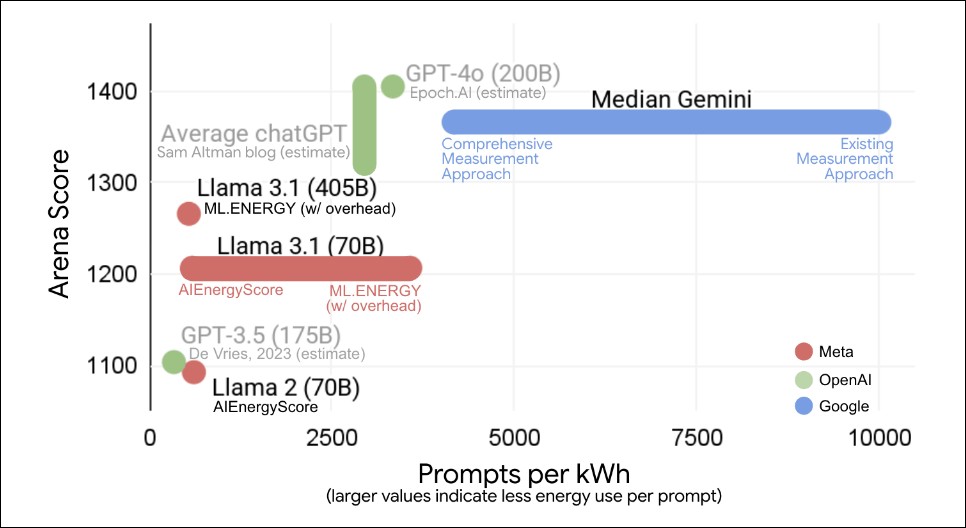

這也代表著AI演算法與硬體技術的綜效優化正迅速邁向可持續的未來。在其公開的圖表中,Google以縱軸表示「AI的性能」,橫軸則代表「每1kWh可處理的token數量」,即能源效率。從圖中可見,Gemini在這兩項指標上皆具優勢,與Meta的Llama 3.1及OpenAI的GPT-4o相比,展現出更為出色的能源利用效率。

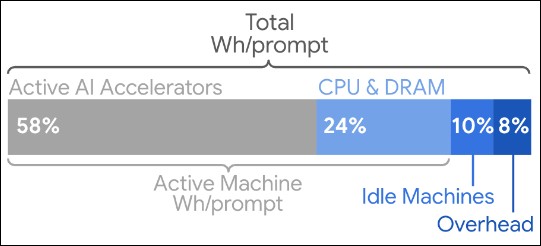

長久以來,AI模型能源消耗的計算多著眼於GPU或TPU等AI運算晶片的功耗,但Google指出,這樣的評估方法過於片面。實際上,在資料中心內支撐AI推理所需的總電力中,只有約58%用於AI晶片運算,其餘42%則消耗於其他關鍵元件與基礎設施,包括:

-

CPU與DRAM的運作電力

-

系統待機(Idle)狀態所需電力

-

冷卻系統與配電設施的能耗

Google強調,若未將這些因素納入考量,將導致低估AI整體的能源與環境影響。為此,Google設計出一套更貼近實際運作情境的計算方法。

實測結果:一次Gemini推理消耗僅0.24Wh電力

在全面考量以上要素的基礎上,Google根據自家資料中心中實際部署的Gemini模型進行量測,並得出以下平均推理成本數據(每個prompt):

-

電力消耗量:0.24Wh(瓦時)

-

二氧化碳排放量:0.03g(克)

-

水資源消耗量:0.26ml(毫升)

為讓一般大眾能更具體理解這些數值,Google進一步比喻道:這相當於觀看電視9秒所需的電力,以及5滴水的耗用量。

作為對比 ChatGPT 每一次回覆約使用 0.34Wh;0.322ml 水:

also, here is one part that people not interested in the rest of the post might still be interested in: pic.twitter.com/ANDhHu9g3g

— Sam Altman (@sama) June 10, 2025

背後技術關鍵:TPU與高效演算法

達成上述成效的背後,除了硬體設計的創新外,Google也強調了軟體與系統整合的貢獻。Gemini的能源效率得以大幅提升,主要歸功於以下兩大因素:

-

高效率演算法選擇:Google在模型設計初期即強調優先使用能源利用率高的架構與方法,降低計算冗餘。

-

TPU硬體優勢:作為Google自研的AI加速器,TPU(Tensor Processing Unit)相較於傳統GPU具備更佳的能源效率與推理速度。TPU的使用使得Gemini能夠以較低能耗完成更多的計算任務。

能源透明化:Google邁向永續AI的重要一步

除了技術本身的突破外,Google也展現出對能源透明化與責任的承擔。在官方部落格與技術論文中,Google公開了所有數據計算的假設條件與方法學,包括:

-

實際運行環境中的功耗監測

-

各類硬體裝置能耗的綜合計算

-

冷卻、水資源與待機能耗的納入

-

資料中心地理區位與碳排放係數的對應

這種高透明度的做法,與過去許多機構僅針對模型效能進行宣傳形成強烈對比,為整個產業樹立了新的基準。

展望未來:AI規模擴張下的能源挑戰與承諾

儘管Gemini在能源效率方面已展現令人振奮的進展,但Google也不諱言,AI應用的快速普及與模型日益龐大仍將帶來可觀的能源需求。如何在技術演進與環境責任之間取得平衡,將是科技業無法迴避的核心議題。

Google表示,未來將持續投入以下幾大方向:

-

更高效的演算法研發

-

TPU等專用硬體的升級迭代

-

資料中心冷卻與電網系統的節能創新

-

與全球可再生能源計畫接軌

Google的承諾不僅是在技術上持續精進,更包含企業社會責任與對永續未來的堅持。

如需更進一步了解Google此次研究背後的技術細節與數據模型,可參考其官方公開之技術白皮書:《Measuring the environmental impact of delivering AI at Google Scale》