近日特斯拉人工智慧團隊副總裁 Ashok Elluswamy 在國際電腦視覺大會(ICCV)上發表了一場主題圍繞特斯拉在自動駕駛領域的最新進展與核心理念的線上演講。同時也揭示了特斯拉如何透過端到端(End-to-End)神經網路架構,並以數據規模與神經模擬為核心,推動現實世界自動駕駛的智慧化。

端到端學習:讓汽車從感知到決策都由AI完成

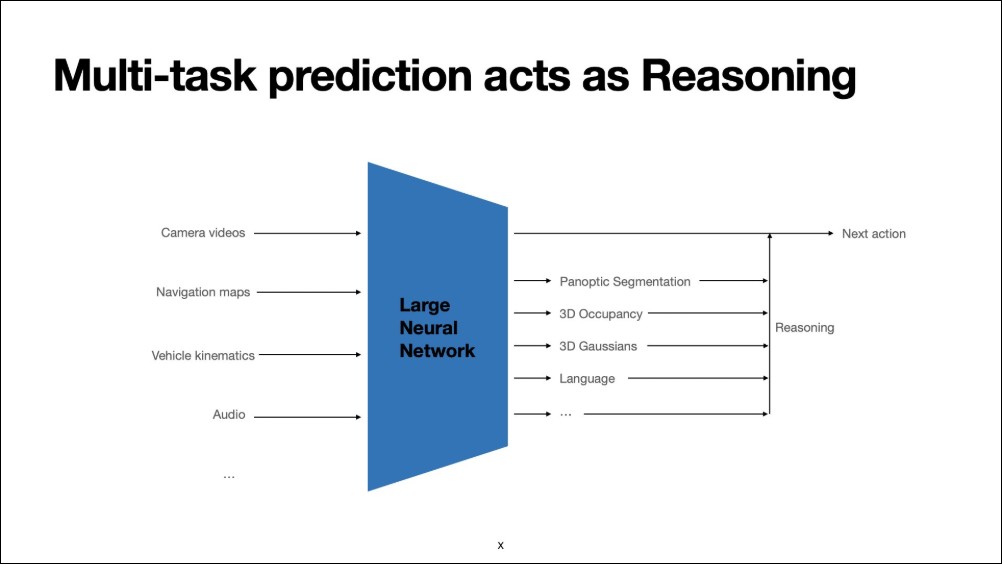

特斯拉的自動駕駛系統(FSD, Full Self-Driving)以端到端神經網路為基礎,直接從車輛的多個攝影鏡頭輸入影像,結合車速、導航地圖、聲音訊號與動態感測數據,生成車輛的控制命令,如轉向與加速。這與多數競爭對手的「模組化自駕架構」形成鮮明對比。後者通常依賴大量感測器,並將系統拆分為感知(Perception)、預測(Prediction)與規劃(Planning)三個部分。雖然此方法在初期開發上較易管理,但當面對現實世界的複雜情境時,其缺乏整體優化能力,難以達成人類駕駛般的直覺判斷。

特斯拉主張,端到端架構的關鍵優勢包括:

-

從數據學習人類價值觀:人類駕駛在決策時會綜合倫理、風險與直覺,這些價值難以以程式碼明確定義,但可透過大數據學習模仿。

-

跨越模組邊界的整合學習:在端到端架構中,誤差梯度可從控制輸出一路反饋至感知輸入,使整個系統在訓練時實現全局最佳化。

-

具可擴展性與一致的運算延遲:同一架構可橫跨數百萬輛車進行同步優化,確保系統延遲可預測且穩定。

-

順應「苦澀的教訓」(The Bitter Lesson):歷史上顯示,隨著算力與數據規模擴張,通用學習方法最終將超越手工設計的規則系統。

他也舉了一些案例:

案例一:水窪與對向車道的抉擇

在一段影片中,AI 必須選擇是否繞過前方大水窪,即便這意味著暫時偏離至對向車道。傳統規則會禁止這樣的行為,但在該場景中,道路空曠、視野良好,AI正確判斷沒有迎面車輛,因而選擇安全繞行。

FSD V12 avoids standing water

(I know hand held phone videos are a no no, and I’m sorry, but I had to share) pic.twitter.com/3vXmJBw0c1

— ΛI DRIVR (@AIDRIVR) February 23, 2024

案例二:理解動物意圖

另外兩段影片展示了AI如何區分兩種場景:一群雞正在過馬路與一群鵝只是停留路旁。傳統模組化系統需定義複雜的行為分類與規劃邏輯,而端到端模型則透過潛在變數(latent representation)自然捕捉這類「意圖」。結果是,AI在無明確規則的情況下,學會了「理解」動物行為的差異。

Why did the chicken cross the road? To see if FSD v12.3 would stop for it.

I didn’t intervene at all.@AIDRIVR @DirtyTesLa @WholeMarsBlog @SawyerMerritt @chazman @Tesla_AI pic.twitter.com/hhgPlmP8gP

— Kyle Westwood (@SnowmanSmasher) March 24, 2024

AJ @OGMarsLife and I made a video today about Actually Smart Summon, and we had some amazing results. For those that need the TLDR, here is a highlight clip, but I recommend heading over to AJ’s post and watching the full video. https://t.co/zlEbJtSIsp pic.twitter.com/OfBAaiJeHT

— Chuck Cook (@chazman) September 28, 2024

克服端到端學習的挑戰

維度詛咒與數據洪流

現實世界的駕駛環境極為複雜,當車輛在路上行駛時特斯拉的自駕系統必須同時處理:

-

7個攝影鏡頭、36幀/秒、每張5百萬像素、30秒歷史紀錄

-

高頻率的車輛動態數據(100Hz)

-

導航地圖與路線資訊

-

高取樣率的音訊資料(48kHz)

這些數據相當於約20億個輸入「token」,而AI最終必須將之壓縮成兩個輸出:轉向角與加速度。要從中學習真實因果關係、避免虛假相關,是一項極具挑戰的任務。所幸,特斯拉擁有全球最大的實車資料庫:每天約等同於一般人 500 年駕駛經驗的數據量。透過高效的資料引擎,特斯拉能從海量資料中挑選最具多樣性與價值的片段,用於訓練AI,提升對罕見情境的泛化能力。

如果使用這類 corner cases 數據進行訓練,就會獲得各種極端情況數據的解法。以下是人工智慧模型如何學習主動避免可能發生的衝突的一個範例。令人印象深刻的是,人工智慧在 5 秒左右做出反應,而情況可能升級為碰撞還很不明顯。人工智慧需要了解外面下著毛毛雨,領頭車可能正在打滑,它可能會撞到障礙物,然後彈回自我車輛的路徑上,因此現在剎車是謹慎的。只有非常有能力的人工智慧系統才能提前預測這些可能發生的狀況。

可解釋性與安全驗證

端到端模型雖強大,但其「黑箱」特性也引發可解釋性與安全性疑慮。特斯拉因此開發了可輸出中間語義標記的架構,讓AI在運作時能生成具意義的「中間推理token」,以便監控與調試。

其中一項代表性技術是生成式高斯點雲(Generative Gaussian Splatting)。傳統3D高斯重建需仰賴寬基線攝影視角,且計算耗時;但特斯拉的生成式方法僅用車載鏡頭即可在約220毫秒內完成高品質3D重建,無需初始化,能同時處理動態物體,並與主AI模型聯合訓練。

此技術能以新視角重建環境,甚至生成語義豐富的自然語言推理,此類模型的輕量版本已運行於FSD v14.x版本之中。

評估與模擬:打造「神經世界」

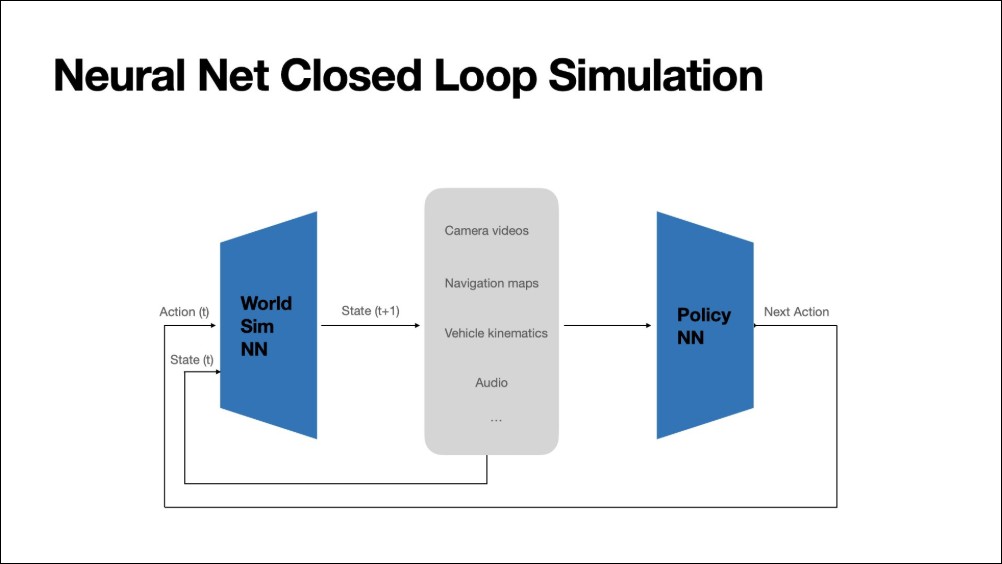

訓練再多數據仍不夠,因為模型在開放式預測上的低損失,並不必然意味現實表現優異。為解決這一難題,特斯拉開發了神經世界模擬器(Neural World Simulator):一個能以封閉循環方式測試AI決策的虛擬環境。

這個模擬器由特斯拉訓練,但其任務是根據當前狀態與動作,預測未來世界狀態。它能生成高解析度、多鏡頭的影像序列,並對駕駛政策模型的指令做出即時反應。(下面的影片不是實拍,而是特斯拉的神經世界模擬模型生成)

模擬器不僅能重現真實駕駛歷史,也能產生對抗性場景(Adversarial Scenarios),用以測試AI在極端條件下的表現。

透過調整計算資源,模擬器能實時生成八個鏡頭、每秒24幀的完整駕駛畫面,讓人類駕駛者在虛擬世界中「實測」AI行為(以下畫面是模擬器即時生成且真的可以駕駛)。

跨界應用:從自駕車到人形機器人

特斯拉強調,這些技術突破不僅服務於自動駕駛,更是通用機器智能(AGI)的基礎。相同的神經世界模擬與視覺生成模型,現已延伸至人形機器人Optimus。

在特斯拉超級工廠內,Optimus利用這套神經模擬環境學習導航與操作任務。影片顯示,不同機器人動作在模擬中被準確反映,顯示出端到端模型與模擬器的高度一致性。這意味著,特斯拉正逐步構建一個車輛與機器人共用的智慧體平台。

更進一步,這樣的模擬系統可用於大規模強化學習(Reinforcement Learning),讓AI在封閉環中無限迭代、超越人類表現,邁向「超人級駕駛與行動智能」。

如果大家對特斯拉人工智慧副總裁 Ashok Elluswamy 在國際電腦視覺大會(ICCV)的演講內容有興趣想深入瞭解的話可以看以下我翻譯好的影片: