過去幾年,科技巨頭與研究機構對於 AI 人工智慧的重點集中於模型訓練與架構創新:從 Transformer 的誕生到多模態生成式模型的崛起,AI 的突破主要發生在訓練與演算法層面。然而,如今的焦點逐漸轉向「推論」:如何讓模型以更低延遲、更高效率的方式服務數億用戶。Google 指出,這場轉變標誌著「AI 推論時代(Age of Inference)」的到來。隨著代理式工作流程(agentic workflows)的興起與通用運算需求激增,現代 AI 系統必須能靈活協調加速運算與一般計算資源。這種趨勢促使 Google 重新構思晶片設計,將軟體與硬體深度整合,打造出專為推論與訓練而生的新世代運算平台 Ironwood TPU 以及全新虛擬機器 Axion。

Ironwood 登場:Google 第七代 TPU 的技術飛躍

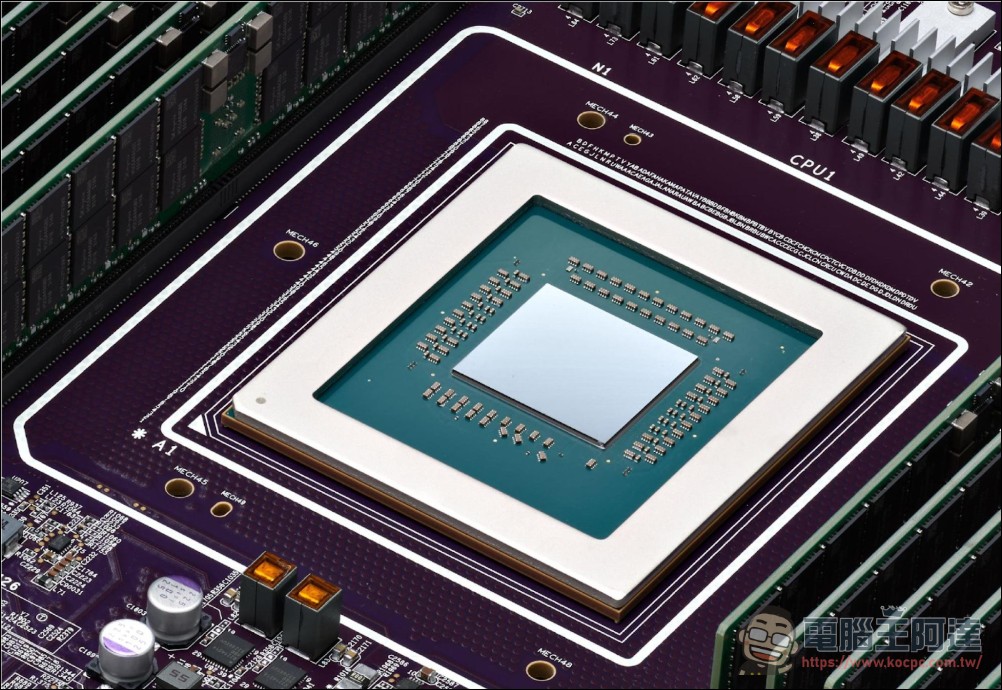

Google 在 2025 年正式揭曉其第七代 TPU:Ironwood,這款晶片被視為公司 AI 硬體發展的里程碑。Ironwood 的設計理念,是在極端負載下同時提供高效能訓練與低延遲推論的能力,滿足當前大型模型與生成式 AI 的龐大運算需求。

根據官方資料,Ironwood 相較於前代晶片展現了驚人的跨代效能提升:

-

對比 TPU v5p:峰值效能提升 10 倍。

-

對比 TPU v6e(Trillium):在訓練與推論工作負載上效能提升超過 4 倍。

這使得 Ironwood 成為 Google 迄今最強大、最節能的客製化晶片,能夠支撐從大型語言模型(LLMs)訓練到即時生成式推論等多種工作負載。

Anthropic、Lightricks、Essential AI 等巨頭搶先採用

Ironwood 一經發表,便迅速吸引多家領先 AI 企業投入部署與測試。

Anthropic 是最早導入 Ironwood 的合作夥伴之一。該公司運算主管 James Bradbury 表示:「我們的 Claude 模型在服務數百萬用戶的過程中,對推論效能與訓練可擴展性的需求與日俱增。Ironwood 的高性價比讓我們能更高效地擴展運算資源,同時維持用戶所期待的速度與可靠性。」Anthropic 預計將使用多達 100 萬顆 TPU 來支撐其模型服務。

Lightricks 研究團隊則利用 Ironwood 強大的晶片間互連網路(Interchip Interconnect, ICI)訓練多模態生成模型 LTX-2,顯著提升效率。該公司總監 Yoav HaCohen 強調:「Ironwood 將讓我們能以更低成本產生更高擬真度的影像與影片內容,持續推動開放式創意的邊界。」

此外,Essential AI 的基礎架構負責人 Philip Monk 也指出:「Ironwood 的高效擴展性與軟體整合度,使我們能專注於 AI 模型的創新,而非系統運維的瓶頸。」

Ironwood 的核心:AI Hypercomputer 的運算中樞

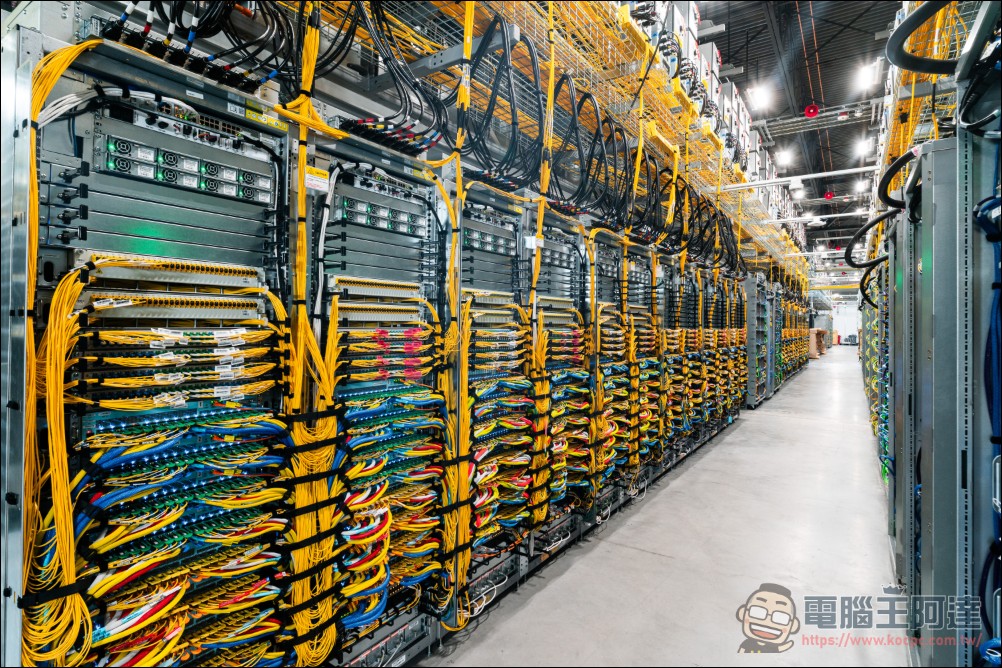

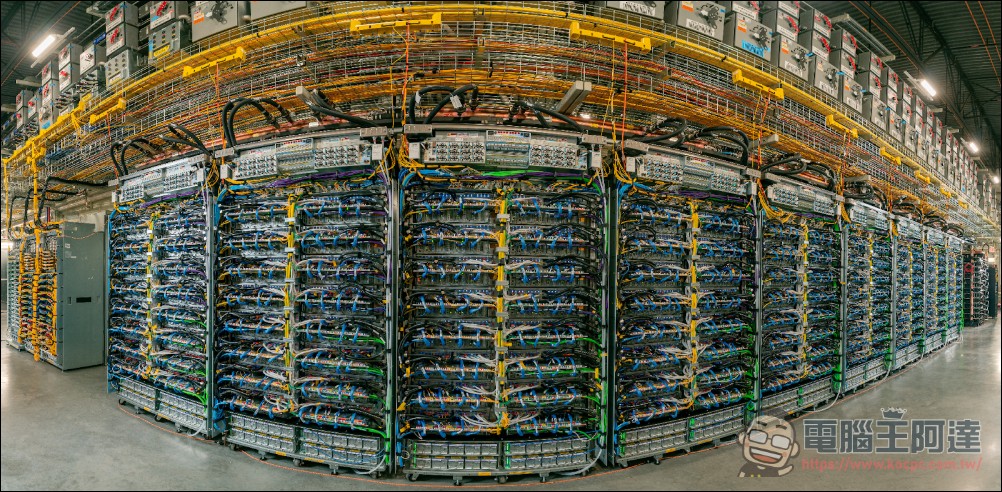

Ironwood 不只是單一晶片,它是 Google AI Hypercomputer 的中樞:一個融合運算、網路、儲存與軟體的整合式超級運算系統。

根據 IDC 報告,導入 AI Hypercomputer 的企業可在三年內達成 353% 投資報酬率、降低 28% IT 成本,並提升 55% IT 團隊效率。

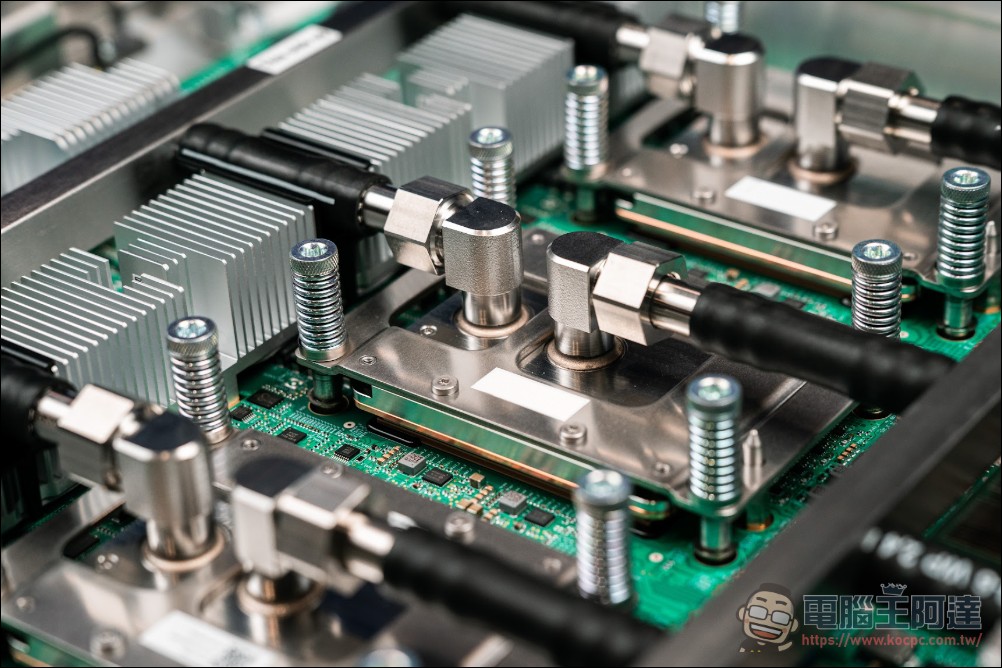

Ironwood TPU 在架構上採用超高密度連結設計:

-

單一 Superpod 可容納 9,216 顆 TPU 晶片。

-

傳輸頻寬 高達 9.6 TB/s。

-

共享高頻寬記憶體(HBM) 高達 1.77 PB。

如此龐大的互聯網路,使數千顆晶片能同步協作,幾乎消除資料傳輸瓶頸。為確保穩定性,Google 導入光學電路交換(Optical Circuit Switching, OCS)技術,能在出現中斷時即時重組網路,確保服務不中斷。若需求擴增,Ironwood 可進一步透過 Jupiter 資料中心網路 形成數十萬顆 TPU 的叢集,構築雲端級超級電腦規模。

Ironwood 的硬體效能,透過 Google 的軟體生態進一步被放大。Google 在 TPU 平台上導入多項創新:

-

GKE Cluster Director:提供拓撲感知與智慧調度功能,讓 TPU 集群能動態分配資源並維持高彈性。

-

MaxText 開源框架:支援最新的監督式微調(SFT)與生成式強化學習(GRPO)技術。

-

vLLM on TPU 支援:讓開發者可無縫切換 GPU 與 TPU,靈活配置推論工作負載。

-

GKE Inference Gateway:優化推論延遲,將首字生成時間(TTFT)縮短高達 96%,並降低約 30% 成本。

透過這些軟體層的強化,Google 成功讓 Ironwood 在訓練、微調與推論的各階段皆達成最高效率,形成真正的「系統級智慧運算平台」。

Axion 登場:Arm 架構 CPU 引領通用運算革新

在 Ironwood 主導的 AI 加速之外,Google 同步推出基於 Arm Neoverse® 架構 的 Axion 系列 CPU,重新定義雲端通用運算的效率與靈活性。

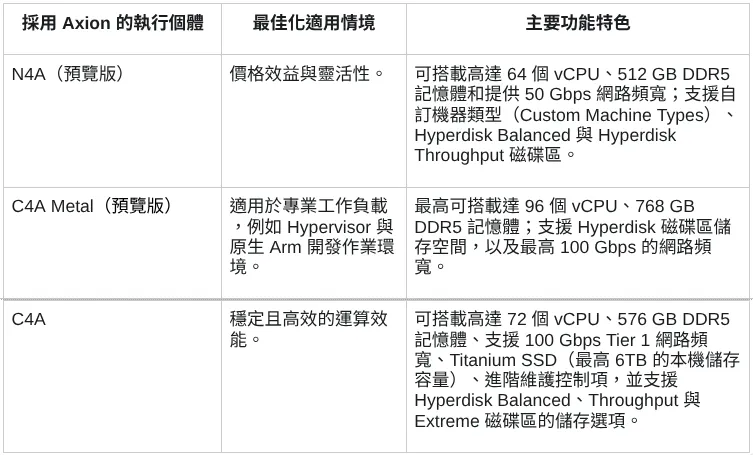

最新發表的兩款產品包括:

-

Axion N4A(預覽版):專為微服務、容器化應用、開源資料庫與資料分析而設計,與同級 x86 VM 相比具備高達 2 倍性價比。

-

Axion C4A metal(預覽版):Google 首款 Arm 架構裸機執行個體,適用於 Android 開發、汽車系統或複雜模擬環境。

這兩款產品與現有的 C4A 一同構成完整的 Axion 產品組合,讓企業能依據工作負載需求,靈活選擇最佳運算方案。

Axion 的實際成效:Vimeo、ZoomInfo、Rise 的成功案例

Vimeo 在使用 Axion N4A 執行影片轉檔測試時,效能提升 30%,無需更改現有架構即可提升單位經濟效益。

ZoomInfo 的資料處理平台在 N4A 上運行後,性價比提升 60%,大幅加速客戶資料分析與洞察生成。

Rise 則透過遷移至 Axion C4A,運算成本下降 20%,同時維持低延遲與高穩定性。該公司正在測試 N4A 系列以支援高彈性 API 服務,並觀察到 CPU 使用量減少 15%,進一步降低雲端支出。

Ironwood × Axion:AI 與通用運算的完美協奏

Google 的戰略清晰明確:以 Ironwood TPU 負責 AI 模型訓練與推論的「智慧核心」,以 Axion CPU 承載日常運算與應用層任務,兩者共同構成 AI 時代的雙引擎架構。

這種垂直整合的設計讓企業能同時獲得極致效能與靈活性,無論是在訓練大型語言模型、部署生成式應用,還是進行資料分析與網頁服務,Google Cloud 的運算平台都能提供最佳組合。