隨著 M5 推出,對於有打算購買新 Mac 且想在本地運行 LLM 語言模型的 Apple 用戶,一定會思考,到底要選目前比較便宜的 M4,還是最新 M5?兩者運行 LLM 有差很多嗎?近日 Apple 在部落格刊登的新文章就能為你解答,實測顯示,M5 本地運行 LLM 的速度遠高於 M4,最大差距還來到 4.1 倍,意味著不用猶豫了,你應該選 M5。

Apple 分享 M5 vs M4 本地運行 LLM 的速度實測差距!M5 提升最高達 4.1 倍

在文章一開始,Apple 再度強調 MLX 的優勢。MLX 是專為 Apple Silicon 優化的開源陣列運算框架,具備高效、彈性與通用性。核心優勢包含:

- 共享記憶體架構(Unified Memory):CPU 與 GPU 可共享記憶體,運算時不需手動搬移資料。

- 類 NumPy API:語法熟悉、彈性且易上手。

- 高階神經網路與最佳化工具:內建自動微分與計算圖最佳化。

而在 Mac 上安裝 MLX 也很簡單,就透過 pip install mlx 指令即可,接著即可利用 MLX LM 來運行大多數 Hugging Face 提供的 LLM。

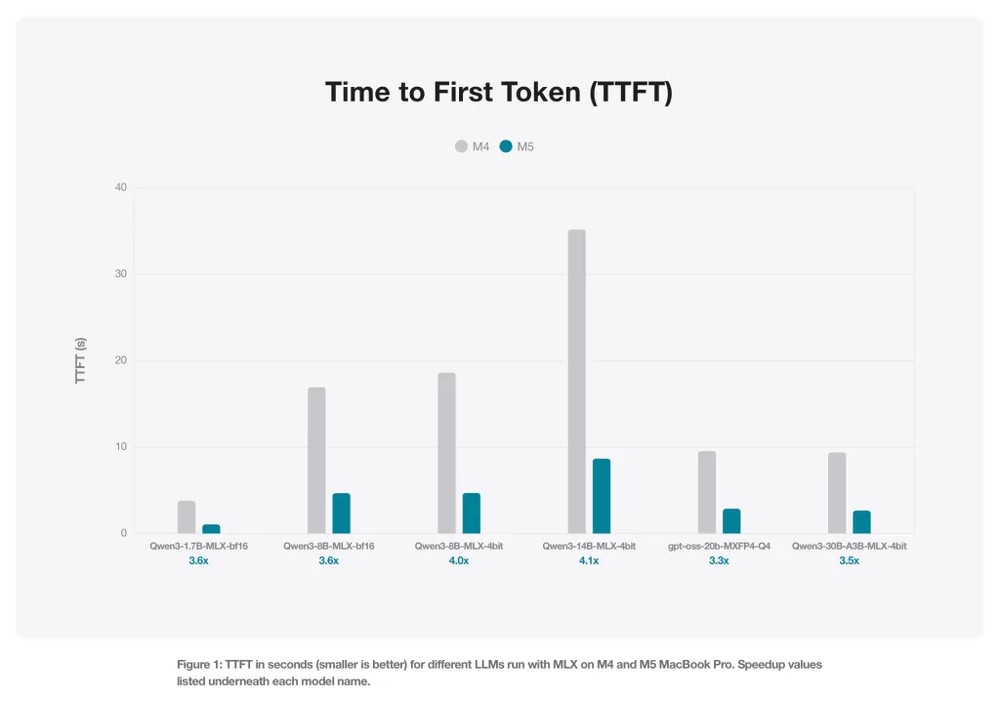

此外,M5 晶片的新 GPU 神經加速器,也大幅提升推理運算效能。為了展示差距,Apple 比較多個開源模型產生第一個 token 所需的時間,包括:

- Qwen 1.7B、8B(BF16 精度)

- Qwen 8B、14B(4-bit 量化)

- Mixture of Experts(MoE):Qwen 30B(3B active / 4-bit)、GPT OSS 20B(MXFP4 精度)

從下圖可以看到,M5 在所有模型上皆有 3.3×~4.1× 的效能提升。TTFT 屬於高度計算密集任務,因此 M5 神經加速器可帶來顯著的提升:

這是各模型的 TTFT 實際秒數差異,前面為 M4,後面則是 M5(越低越好):

- Qwen3-1.7B:3.79s → 1.06s

- Qwen3-8B:16.92s → 4.67s

- Qwen3-8B 4bit:18.6s → 4.69s

- Qwen3-14B 4bit:35.15s → 8.66s

- GPT-OSS-20B:9.54s → 2.87s

- Qwen3-30B MoE:9.37s → 2.66s

以下是 M5 的測試成績:

| 模型 | TTFT 加速比 | 生成加速比 | 記憶體(GB) |

|---|---|---|---|

| Qwen3-1.7B-MLX-bf16 | 3.57 | 1.27 | 4.40 |

| Qwen3-8B-MLX-bf16 | 3.62 | 1.24 | 17.46 |

| Qwen3-8B-MLX-4bit | 3.97 | 1.24 | 5.61 |

| Qwen3-14B-MLX-4bit | 4.06 | 1.19 | 9.16 |

| gpt-oss-20b-MXFP4-Q4 | 3.33 | 1.24 | 12.08 |

| Qwen3-30B-A3B-MLX-4bit | 3.52 | 1.25 | 17.31 |

由此可見,M5 是目前在本地運行 LLM 大型語言模型的最佳 Mac 平台,多了 GPU 神經加速器讓推論速度大幅提升。

這篇文章中還有展示 M5 其他方面的測試,有興趣的人可以至 Apple 原文閱讀。