不到三個月的時間,DeepSeek 近日再度於視覺理解(VLM)領域丟出震撼彈,正式發佈採用全新升級版光學字符辨識(OCR)DeepSeek OCR 2。這項技術徹底顛覆了傳統 AI 對影像「由左至右、由上而下」的機械式掃描模式,改採模仿人類視覺邏輯的靈活處理方式,不僅號稱在文件解析精準度上超越了 Google 的 Gemini 3 Pro,更實現了前所未有的極高運算效率。

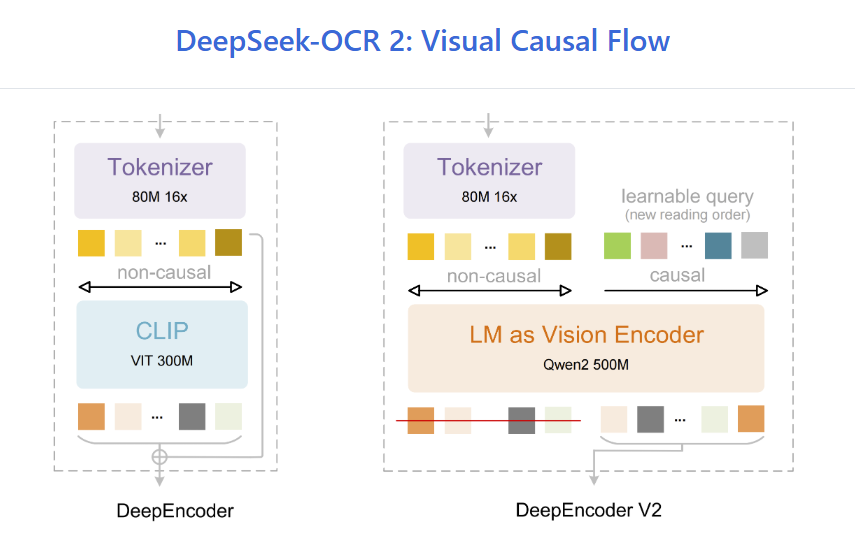

DeepSeek OCR 2 技術核心:DeepEncoder V2 與「視覺因果流」

DeepSeek OCR 2 之所以強大,在於其底層架構 DeepEncoder V2 的革命性設計「視覺因果流」(Visual Causal Flow):

- 捨棄傳統組件:研發團隊將業界通用的 CLIP 組件更換為基於 Qwen2 0.5B 的小型語言模型,強化了系統對細節的初步理解。

- 模仿人類視線:引入獨創的「視覺因果流」(Visual Causal Flow)。這些可學習的查詢 Token 能在正式進入大型語言模型處理前,先根據影像上下文重新組織視覺資訊。這意味著系統是先「看懂」二維畫面的關聯,而非單純的像素掃描,這讓它在處理排版混亂、佈局複雜的文件時具有極大優勢。

驚人的效率:用 20% 的算力做更好的事

在效能評測中,DeepSeek OCR 2 展現了令人咋舌的節能效果:

- Token 消耗極低:一般同類模型解析一張圖通常需要 6,000 個以上的 Token,但 DeepSeek OCR 2 僅需 256 至 1,120 個視覺 Token。這意味著在相同任務下,它能節省約 80% 的運算資源(Token 使用量)。

- 實測超越旗艦機型:根據 OmniDocBench v1.5 的權威測試,DeepSeek OCR 2 的整體得分高達 91.09%。在文件解析任務中,其精確度與防止重複文字生成的表現,甚至優於擁有龐大運算預算的 Google Gemini 3 Pro。

儘管 DeepSeek OCR 2 在處理高文字密度的極端場景(如微型字體的報紙)仍有進步空間,但其 DeepEncoder V2 架構被視為邁向「統一多模態處理」的重要基石。研究團隊指出,未來此架構有望無縫整合文字、語音與影像,實現真正的全維度內容理解。

目前,DeepSeek 一如往常的將該模型的代碼與權重於 GitHub 與 Hugging Face 全面開源,這不僅為開發者提供了極其高效的工具,也預計將加速全球高品質 AI 訓練數據集的生成速度。

結語:AI 算力競賽的轉折點?

DeepSeek OCR 2 的出現再次證明:如同當年的 DeepSeek V3 那樣,AI 的進化不一定非要靠堆疊算力,透過更優雅的演算法與架構設計,同樣能達到甚至超越頂級旗艦的效果。這對於追求高效能、低成本部署的企業與開發者而言,無疑是 2026 年初最重要的一份大禮。