在人工智慧與穿戴式裝置日益融合的當下,X平台上一位名為 @_seanliu(xiaoan/Sean Liu)的開發者日前在 GitHub 上發布了一項令人矚目的開源專案:VisionClaw。這款基於 OpenClaw 開源 AI 助理專門針對 Meta Ray-Ban 智慧眼鏡量身打造,巧妙結合了 Meta Wearables SDK、Google Gemini Live API 以及 OpenClaw Gateway 三大核心技術,讓使用者能夠透過語音與視覺互動,體驗真正的隨身智慧助手。

結合智慧眼鏡 × Gemini × OpenClaw,「看的到」的隨身 AI 助理 VisionClaw

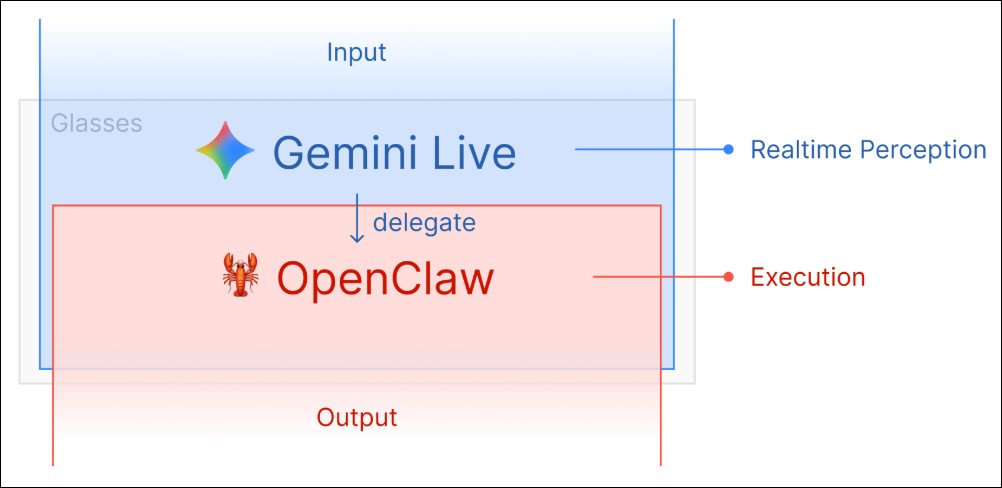

三層架構:從感知到執行的完整智慧鏈

VisionClaw 的設計採用了清晰的三層架構,將穿戴裝置的感知能力、雲端 AI 的大腦運算,以及開源工具的執行力完美串連。

- 感知層(Meta Ray-Ban): 眼鏡相機以每秒約一張的頻率拍攝影像,麥克風則持續收錄使用者的語音指令。這些原始數據隨即被傳送至下一層進行處理。

- 大腦層(Gemini Live API): 透過 WebSocket 連線,Gemini 能夠即時處理音訊與視覺資訊,實現毫秒級的回應速度。值得注意的是,這並非傳統的語音轉文字(STT)→ 大型語言模型(LLM)→ 語音合成(TTS)流程,而是一種更為直接的低延遲處理方式,讓對話體驗更加自然流暢 。

- 執行層(OpenClaw Gateway): 當 Gemini 分析完使用者的需求後,會透過 Tool Calling 機制發送指令給 OpenClaw,進而調用其提供的 56 種以上 Skills 來完成實際任務。這種設計將 AI 的「思考」與「行動」有效分離,確保每一個指令都能被精準執行。

多元應用場景:生活、商務、學習一手掌握

VisionClaw 的應用潛力極為廣泛,涵蓋了日常生活的各個層面:

• 場景辨識:詢問「我在看什麼?」,Gemini 透過眼鏡相機即時辨識周圍場景並給出描述

• 訊息傳送:「傳訊息給 John 說我遲到 5 分鐘」→ 自動透過 WhatsApp 或 iMessage 完成發送

• 語音購物:「幫我買牛奶」自動加入購物清單;看到商品直接語音下單

• 演講記錄:聆聽演講或會議時,即時記錄投影片與語音,傳回電腦整理成結構化筆記

直接讓 AI 以看見的物品去亞馬遜上搜尋商品:

now my clawdbot lives in my ray-ban meta glasses so i can just buy whatever i’m looking at pic.twitter.com/gWrijyTRhE

— xiaoan (@_seanliu) February 6, 2026

iPhone 模式:降低門檻,歡迎所有人體驗

考量到並非所有使用者都擁有 Meta Ray-Ban 智慧眼鏡,VisionClaw 也特別設計了 iPhone 模式。使用者可以透過 iPhone 的鏡頭模擬眼鏡的視覺輸入,測試完整的互動流程,大幅降低了體驗門檻。

系統需求方面,VisionClaw 需要 iOS 17.0 或更高版本、Xcode 15.0 以上,以及使用者自己的 Gemini API key。OpenClaw Gateway 為可選安裝:裝了才有 56 種以上 Skills 的執行能力。

技術規格:為效率而生的音視訊處理

在音訊處理方面,VisionClaw 採用 PCM Int16 格式、16kHz 採樣率的音訊輸入,回傳則使用 PCM 24kHz 格式,確保語音互動的清晰度。視訊方面,眼鏡相機原本的 30fps 影片被降速至約每秒一張,並以 JPEG 50% 品質壓縮後傳送給 Gemini,既保留了足夠的視覺資訊,又不會造成頻寬負擔。

Tool Calling 的實現方式同樣值得關注:開發者僅需宣告一個 execute 工具,所有複雜的任務便會自動路由至 OpenClaw 處理,簡化了整體系統的擴展性與維護性。

VisionClaw GitHub

總結

VisionClaw 的開源釋出,不僅是一項開源技術成果的展示,更預告了 AI 應用開發的新範式。當硬體、雲端 AI 與開源工具能夠自由組合,每一位開發者都有機會成為下一代智慧助理的創造者。這或許正是開源精神在 AI 時代的最佳體現:打破藩籬,讓創意自由流動。我個人也很期待有公司或作者能將其產品化,也許能讓 OpenClaw 造福更多人且更好用。