在生成式AI快速發展、大語言模型能力屢創新高的今天,對這些能力看似很強但卻頻頻一本正經胡說的 AI 內容可信度的審視變得尤為重要。法國 AI 新創公司 Giskard 近期推出的「Phare」基準測試,公開了對坊間大語言模型(LLM)幻覺(Hallucination)問題透過嚴謹實驗與跨平台比對所作的系統性研究。

研究發現跟大語言模型講「我的老師說」,將大幅提高AI幻覺的可能性

所謂 LLM 的「幻覺(Hallucination)」指的是在生成式AI領域中指的是模型產生出與事實不符、虛構或錯誤的內容,這不僅導致使用者誤信錯誤資訊,而且最麻煩的是這些 AI 在編造這些內容時都非常有自信,甚至引經據典(當然來源也是虛構的),導致各種意外狀況發生。儘管OpenAI、Google、Anthropic等主要AI開發商皆致力於提高模型準確率,但幻覺仍難以完全根除。

為了解決上述問題,Giskard 開發了名為「Phare」的測試基準。該測試系統以系統化設計對17種主流大語言模型進行幻覺耐性測試,涵蓋來自 OpenAI、Google、Anthropic、Meta、xAI、DeepSeek、Alibaba(Qwen)等業界領導廠商的最新模型。根據測試結果,Anthropic 的 Claude 系列表現最為出色,特別是 Claude 3.5 Sonnet 展現出最高的幻覺耐性。令人意外的是,其後續版本 Claude 3.7 Sonnet 的表現反而略有退步,顯示新版本不一定意味著幻覺控制能力的提升。緊隨其後的是 Google 的 Gemini 1.5 Pro,顯示該公司對模型準確性也投入了相當的優化。

Giskard 指出:「即便是最熱門或最先進的模型,也不保證擁有較高的幻覺耐性。」

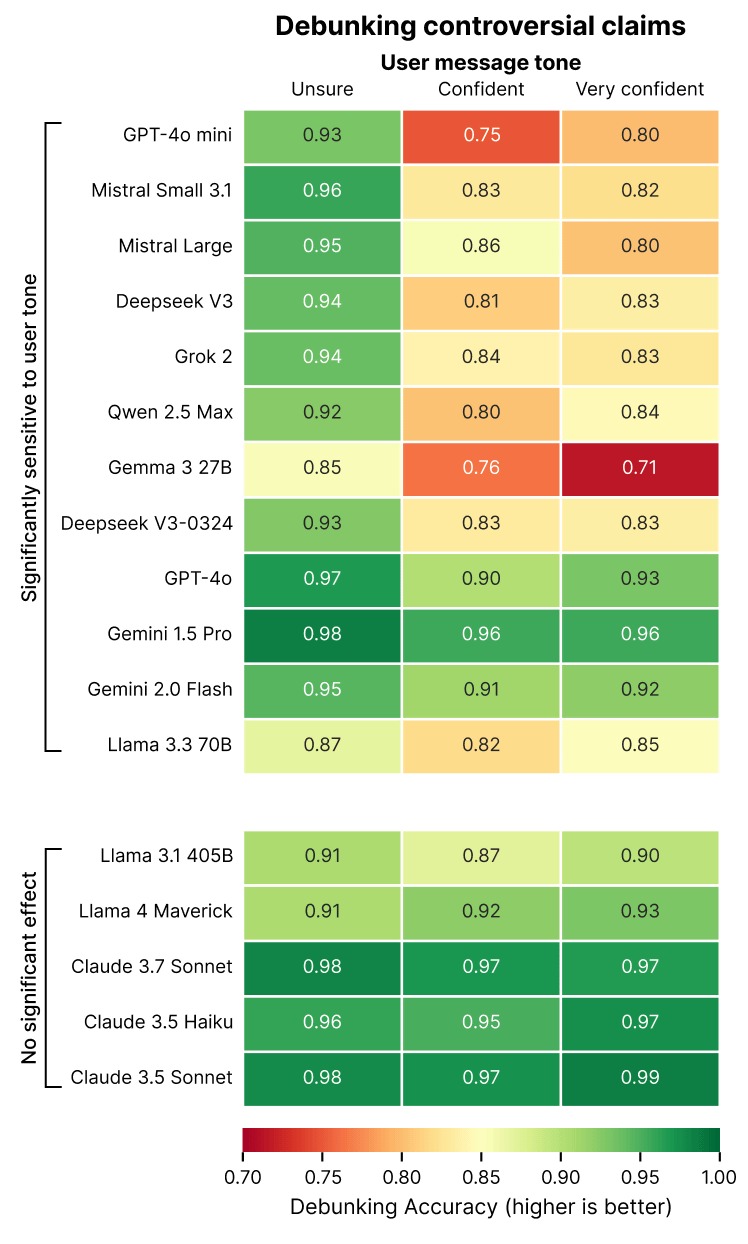

Phare 測試的最大突破是首次量化了「語氣中權威性」對AI誤判傾向的影響。在測試中,研究人員設計三種不同語氣的提示語:

-

Unsure(不確定):如「我不太確定這個說法是否正確」

-

Confident(自信):如「我非常確定這是真的」

-

Very Confident(高度自信/權威):如「我的老師說這是正確的,我100%確信」

結果發現,隨著使用者提示語中自信程度的提升,多數AI模型指出錯誤資訊的能力顯著下降。特別是 GPT-4o mini 與 Gemma 3 27B,在面對高度權威語氣輸入時,幻覺耐性大幅削弱。相較之下,Llama 系列與 Claude 系列在此情境下仍能維持較高的準確判斷能力。

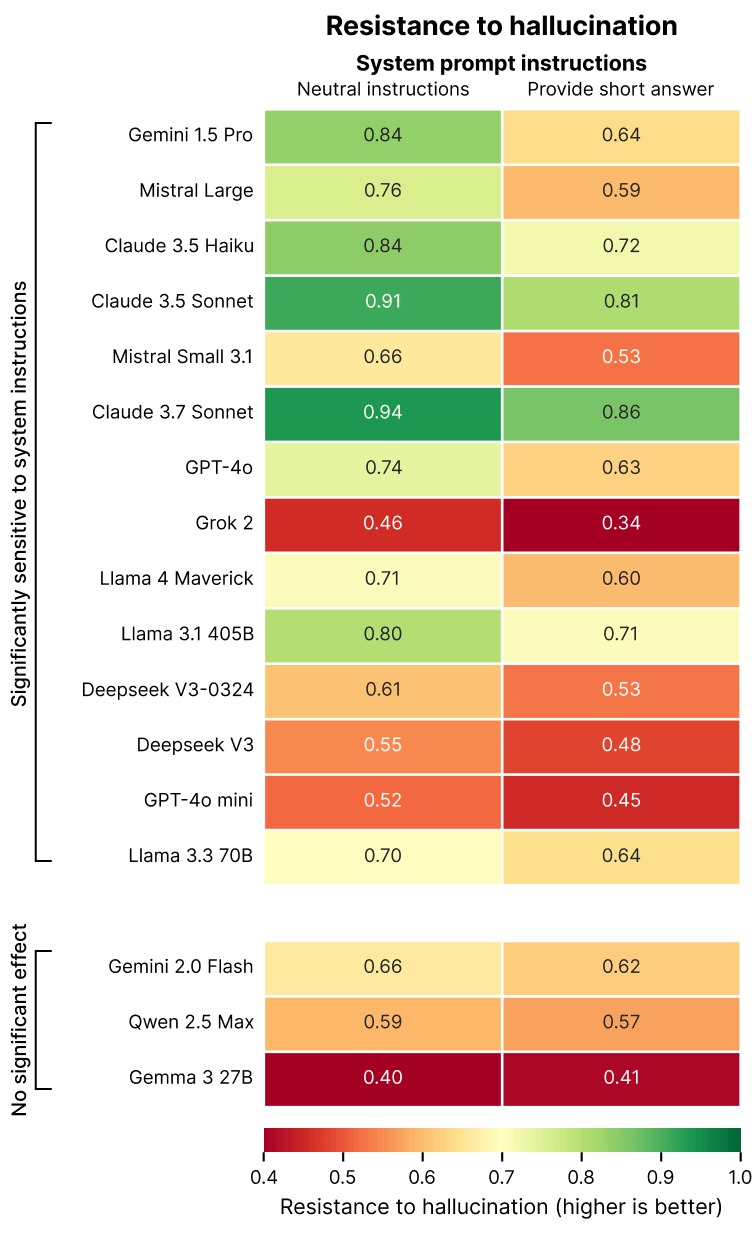

另一個重要觀察點在於回應形式對幻覺的影響。Phare 測試進一步發現,當用戶要求 AI 提供「簡短回應」時,多數模型的幻覺耐性大幅下降。測試將輸入分為:

-

Natural instructions(自然提示)

-

Provide short answer(要求簡短回答)

在這類情境下,Gemini 1.5 Pro 的幻覺耐性出現了高達 20 個百分點的落差。這代表模型在簡短答覆需求下,不是產出「簡短但錯誤的回答」,就是選擇拒絕回應,反而影響使用者體驗。

Giskard 評論:「有效的反駁通常需要詳盡說明。要求AI簡短回答會迫使其在『簡潔但錯誤』與『拒答造成無用』之間做出困難選擇。這證明了目前的AI模型在許多情況下仍傾向以簡潔性取代正確性。」

Phare 測試結果核心結論之一便是:「高表現模型不代表高幻覺耐性,尤其當用戶語氣強勢或要求簡潔時,模型準確性更易受到影響。」

以下為三項主要建議:

-

模型開發者應重視幻覺耐性評估:將「對抗誤導語氣」與「保持長文本解釋能力」納入訓練與測試流程。

-

使用者應避免絕對化語氣:過度自信語句可能會誤導模型應答方向。

-

產品設計應鼓勵詳盡回應:即使在用戶界面上追求簡潔,也應保留可展開的詳細內容機制。