近日 Google 正式發表了其最新輕量級多模態AI模型「Gemma 3n」,這是一款集高效能、低資源需求、開源彈性於一身的新型AI模型,並同步公開了技術細節與基準測試數據。Gemma 3n最初於2025年5月以早期預覽版形式登場,其特色在於極小模型尺寸與多模態支援,能在記憶體資源有限的設備,如手機上本地端運行(我們也有寫使用教學),卻仍保有驚人的語言理解與生成能力。如今,該模型正式版本正式推出,不僅延續了預覽版的技術基礎,更進一步優化了性能表現。

Google正式推出可在手機端運行的輕量級多模態AI模型「Gemma 3n」

Google在AI領域的代表作「Gemini」系列以其卓越的推理與生成能力廣受矚目,然而,Gemini 因參數量巨大,僅能透過 Google 自家的應用程式或 API 進行存取,並不提供原始模型權重的下載與客製化應用。這種封閉式的策略儘管保障了品質控制與商業模式,但對於需要更大自由度的研究者與開發者而言,使用限制甚多。

與此相對,Gemma系列自推出以來便堅持開放原始權重的開發理念。無論是雲端應用、邊緣設備還是學術研究,開發者都可自由下載模型並部署於各種平台,極大地促進了社群的創新速度。Gemma的命名靈感來自「Gemini」與「open model」的結合,主打「親民、開放、好上手」,在保持優異效能的同時追求低資源佔用與高度相容性。而這次推出的 Gemma 3n 主要特點就是僅數 GB 的模型體量還支援多模態,可在手機端本地運行。

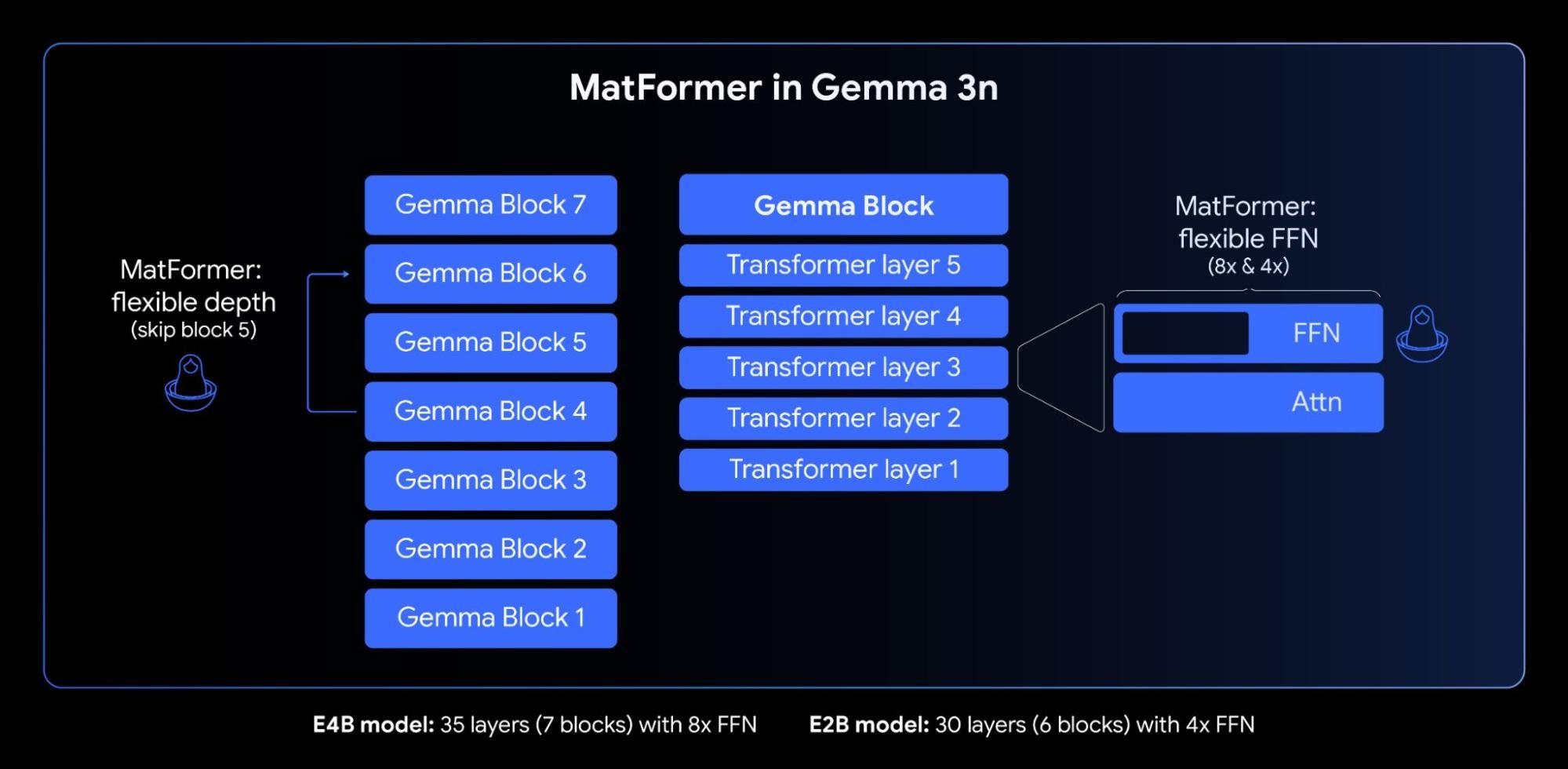

Gemma 3n 採用了Google自家設計的「MatFormer」架構。該架構的創新之處在於一種巢狀模型訓練方式。Google將其比喻為「俄羅斯娃娃」:在大型模型中同時內嵌一個能獨立運作的小型版本。以此次釋出的主力模型「Gemma 3n E4B」為例,其在訓練過程中同步優化了一個較小的子模型「Gemma 3n E2B」。兩者共用架構與知識,但根據用途與設備資源不同,可選擇部署不同尺寸的模型,大幅提高彈性與擴展性。

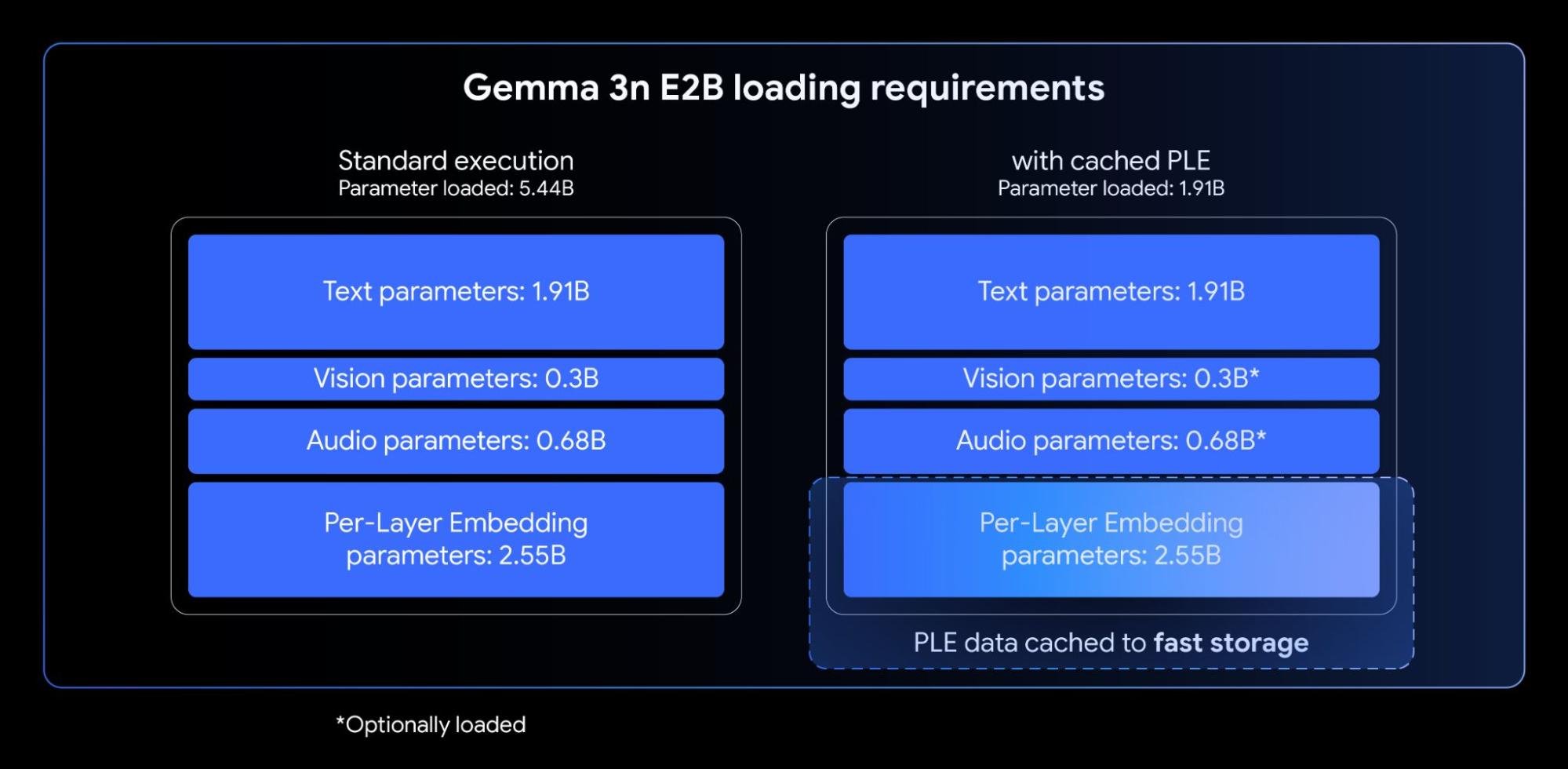

為了讓AI能在智慧手機或其他低資源設備上本地執行,Google引入了一項稱為「Per-Layer Embeddings(PLE)」的創新技術。該方法可顯著減少模型運行時需載入的資料量,使得儘管Gemma 3n E2B擁有高達50億參數,其實際記憶體消耗卻與傳統20億參數模型相當。

這使得E2B能夠僅使用2GB記憶體運行,而E4B(80億參數)則在3GB記憶體下便能順暢執行。這對於需要高效部署的嵌入式裝置而言,無疑是一大突破。

性能表現不容小覷,超越多款商用模型

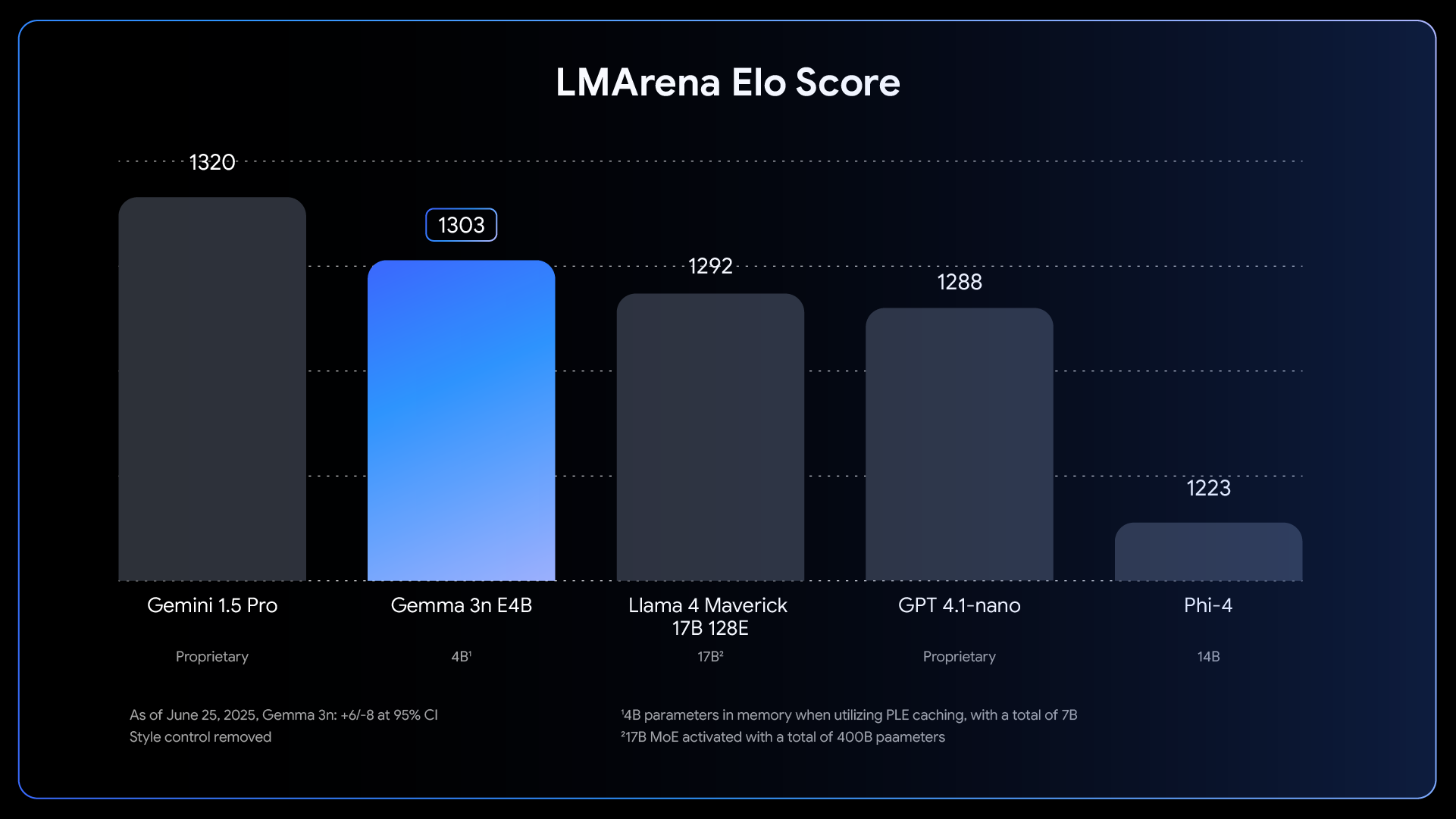

Google官方釋出了一項將Gemma 3n E4B與多款主流AI模型進行比較的基準測試。結果顯示,Gemma 3n E4B在聊天任務中的表現不僅超越同為開源模型的「Llama 4 Maverick 17B-128E」與「Phi-4」,甚至優於OpenAI推出的商用模型「GPT-4.1-nano」。

支援多模態輸入,平台相容性極高

Gemma 3n不僅支援純文字輸入,還具備處理圖片、聲音乃至影片等多模態輸入的能力,為開發更多元應用場景提供了基礎。

此外,其可在多個主流程式執行平台運行,包括:

-

Hugging Face Transformers

-

llama.cpp

-

Google AI Edge

-

Ollama

-

Apple 的 MLX 框架

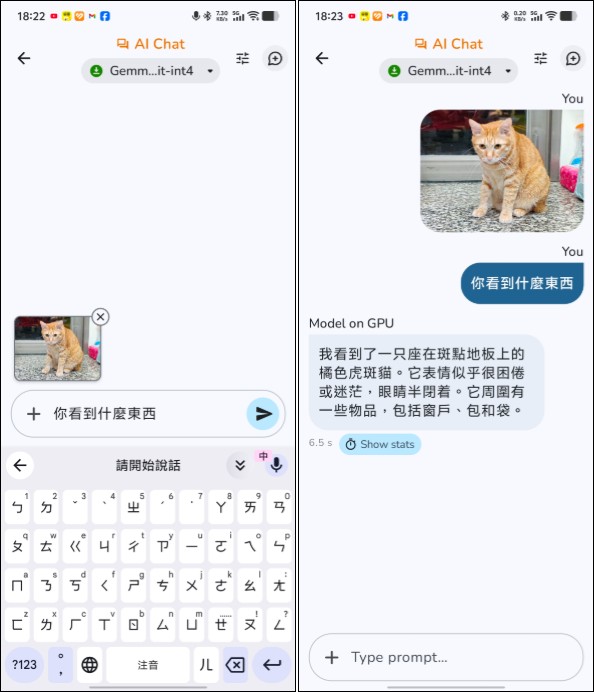

更令人驚喜的是,Gemma 3n 已整合至Google推出的智慧手機AI平台「Google AI Edge Gallery」,可直接於 Android 裝置上進行本地運行與測試。經小編測試,該模型在 Pixel 裝置上的聊天體驗流暢自然,具備「隨身AI助理」的潛力(不過我自己測不出聲音與影像的解析功能)。

開發與測試資源豐富,降低門檻

除了模型權重的開放下載,Google也同步推出了多項工具支援Gemma 3n的開發與部署。開發者可透過「Google AI Studio」快速進行線上聊天測試,驗證模型表現,無需自行架設推論伺服器,大幅降低實驗與原型開發的門檻。此外,Gemma 3n的原始碼與文檔也公開於Hugging Face與Google Developers Blog,提供清晰的API介面與訓練指南。Gemma 3n的正式版本現已可透過Hugging Face與Kaggle下載,有興趣的朋友可以依照我們之前的教學直接下載測試。