AI 模型雖然越來越強,但幻覺的問題一直都存在(也就是一本正經地胡說八道),也因此核對回答至今依舊是非常重要的一環。而很多人一定會好奇,為何語言模型會有幻覺?根本原因到底是什麼?稍早 OpenAI 就為此提出了解釋,同時也認為這是有解的,但就目前來說還有一段路。

為什麼語言模型會產生幻覺?OpenAI 作出解釋,並提出解決方案

所謂的幻覺(hallucinations),是指語言模型非常有信心的生成答案,但內容卻都是錯的,相信很多人都曾碰過。而為了解決這問題,網路上就出現一些提問技巧,來有效降低幻覺率,像是:

- 提供清晰的背景資訊

- 要求 AI 引用來源

- 把複雜問題拆解成小問題

獲得答案時,也能使用線上搜尋的功能來交叉比對,Gemini 就有所謂的「查證回覆內容」功能,甚至是反向提問 AI。

OpenAI 表示,語言模型之所以會有幻覺,是因為標準的訓練和評估程序,都偏向於獎勵「猜測」,而不是「承認不確定」。

幻覺持續存在的部分原因,是現在的「評估方式」都設錯誘因,大多數的評估方法都是以「答對率」來衡量模型表現,這意味著,碰到模型沒辦法確定的答案,反而鼓勵去猜,而不是誠實表達不知道。

OpenAI 用考試來舉例,如果你不知道答案,亂猜就有機會答對,進而提高正確率,但空白則一定是零分。

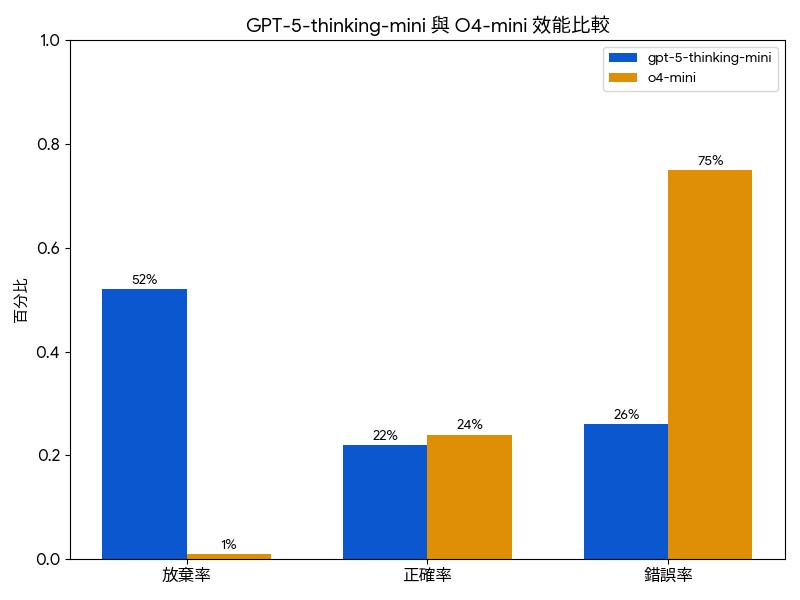

以下是兩個模型的 SimpleQA 測試成績:

- gpt-5-thinking-mini:放棄率 52%,正確率 22%,錯誤率 26%。

- o4-mini:放棄率 1%,正確率 24%,錯誤率 75%。

如果單就正確率來說,o4-mini 的 24% 更優秀,但錯誤率(幻覺比例)就非常慘,高達 75%,gpt-5-thinking-mini 因為放棄許多不確定的答案,錯誤率直接降到 26%。

目前的排行榜大多都是追求正確率,這就導致開發者設計的模型時,更傾向「去猜」,而不是「誠實回答」,這也是為什麼即便模型越來越強,依舊有幻覺的問題。

所以要解決這問題,OpenAI 認為主流的評估方式必須重新設計。

一般也有一些誤解,認為「提升正確率就能消除幻覺」,因為 100% 正確就不會有幻覺。但實際上正確率永遠不可能達 100%,因為有些問題本質上就是無解,就像是現實生活一樣。

還有人認為「如果要避免幻覺,需要具有更高度智慧的大模型」,OpenAI 表示小模型其實更容易知道自己「不懂」,如:被問到毛利語相關的問題(Māori question),小模型會直接說「我不知道」,比起半懂不懂還要去衡量信心的大模型,小模型回答更乾脆。

文章中也有提到,幻覺是源自於預訓練階段,模型在預訓練時的任務是「在大量文字中預測下一個詞」,而不是判斷句子真假。因此,由於缺乏「對/錯」的標籤,模型很難區分正確與錯誤的內容,看到的都是語言正面例子。

如果你想要更了解 OpenAI 發表的內容,可以到官網閱讀完整文章。